Совместная сегментация объектов - Object co-segmentation

В компьютерное зрение, совместная сегментация объектов это частный случай сегментация изображения, который определяется как совместное сегментирование семантически похожих объектов в нескольких изображениях или видеокадрах.[2][3].

Вызовы

Часто бывает сложно извлечь маски сегментации цели / объекта из зашумленной коллекции изображений или видеокадров, что включает открытие объекта в сочетании с сегментация. А шумная коллекция подразумевает, что объект / цель периодически присутствует в наборе изображений или объект / цель периодически исчезает на протяжении всего интересующего видео. Ранние методы[4][5] обычно включают представления среднего уровня, такие как предложения объекта.

Методы на основе динамических сетей Маркова

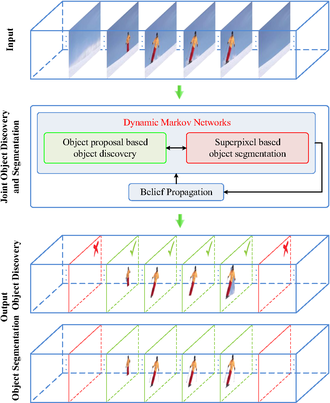

Совместный метод обнаружения объектов и совместной сегментации на основе связанных динамических Марковские сети был предложен недавно[1], в котором заявлено о значительном улучшении устойчивости к нерелевантным / шумным видеокадрам.

В отличие от предыдущих попыток, которые удобно предполагали постоянное присутствие целевых объектов во всем входном видео, этот связанный алгоритм на основе двойной динамической сети Маркова одновременно выполняет задачи обнаружения и сегментации с двумя соответствующими сетями Маркова, совместно обновляемыми посредством распространения убеждений.

В частности, марковская сеть, отвечающая за сегментацию, инициализируется суперпикселями и предоставляет информацию для своего марковского аналога, отвечающего за задачу обнаружения объектов. И наоборот, сеть Маркова, ответственная за обнаружение, строит граф предложения объекта с входными данными, включая трубки пространственно-временной сегментации.

Методы, основанные на вырезании графа

Вырезать график оптимизация - популярный инструмент компьютерного зрения, особенно в более ранних сегментация изображения Приложения. В качестве расширения регулярных разрезов графов предлагается многоуровневое разрезание гиперграфов.[6] для учета более сложных соответствий высокого порядка между видеогруппами за пределами типичных парных корреляций.

С таким расширением гиперграфа множество модальностей соответствий, включая внешний вид низкого уровня, заметность, когерентное движение и функции высокого уровня, такие как области объекта, могут быть легко включены в вычисление гиперребра. Кроме того, в качестве основного преимущества перед совпадение основанный на подходе, гиперграф неявно сохраняет более сложные соответствия между его вершинами, а веса гиперребер удобно вычислять с помощью разложение на собственные значения из Матрицы лапласа.

Методы на основе CNN / LSTM

В локализация действия Приложения, совместная сегментация объектов также реализован как сегментная трубка пространственно-временной детектор[7]. Вдохновленный недавними попытками локализации пространственно-временного действия с помощью тублеток (последовательностей ограничивающих рамок), Ле и другие. представить новый детектор локализации пространственно-временного действия Segment-tube, который состоит из последовательностей покадровых масок сегментации. Этот детектор сегментной трубки может временно определять начальный / конечный кадр каждой категории действий при наличии предшествующих / последующих действий помех в необрезанном видео. Одновременно с этим детектор «Сегмент-трубка» создает покадровые маски сегментации вместо ограничивающих прямоугольников, обеспечивая превосходную пространственную точность для трубок. Это достигается путем чередования итеративной оптимизации между временной локализацией действия и пространственной сегментацией действия.

Предлагаемый сегментно-трубчатый детектор показан на схеме справа. Образец входных данных представляет собой необрезанное видео, содержащее все кадры в видео парного фигурного катания, причем только часть этих кадров относится к соответствующей категории (например, DeathSpirals). Инициализированный сегментацией изображения на основе значимости на отдельных кадрах, этот метод сначала выполняет этап временной локализации действия с каскадным 3D CNN и LSTM, и точно определяет начальный и конечный кадры целевого действия с помощью стратегии от грубого к точному. Затем детектор сегментной трубки уточняет покадровую пространственную сегментацию с вырезать график фокусируясь на соответствующих кадрах, идентифицированных на этапе локализации временного действия. Оптимизация чередуется между временной локализацией действия и пространственной сегментацией действия итеративным образом. После практической конвергенции конечные результаты пространственно-временной локализации действия получаются в формате последовательности масок сегментирования по кадрам (нижняя строка в блок-схеме) с точными начальными / конечными кадрами.

Смотрите также

- Сегментация изображения

- Обнаружение объекта

- Анализ видео контента

- Анализ изображений

- Цифровая обработка изображений

- Распознавание активности

- Компьютерное зрение

- Сверточная нейронная сеть

- Долговременная кратковременная память

использованная литература

- ^ а б c d Лю, Цзыи; Ван, Ле; Хуа, банда; Чжан, Цилинь; Ню, Чжэньсин; У, Инь; Чжэн, Наньнин (2018). «Совместное обнаружение и сегментация видеообъектов с помощью связанных динамических сетей Маркова» (PDF). IEEE Transactions по обработке изображений. 27 (12): 5840–5853. Bibcode:2018ITIP ... 27.5840L. Дои:10.1109 / tip.2018.2859622. ISSN 1057-7149. PMID 30059300. S2CID 51867241.

- ^ Висенте, Сара; Ротер, Карстен; Колмогоров, Владимир (2011). Сосегментация объектов. IEEE. Дои:10.1109 / cvpr.2011.5995530. ISBN 978-1-4577-0394-2.

- ^ Чен, Дин-Цзе; Чен, Хванн-Цзонг; Чанг, Лун-Вэнь (2012). Сосегментация видеообъектов. Нью-Йорк, Нью-Йорк, США: ACM Press. Дои:10.1145/2393347.2396317. ISBN 978-1-4503-1089-5.

- ^ Ли, Ён Джэ; Ким, Джечоль; Грауман, Кристен (2011). Ключевые сегменты для сегментации видеообъектов. IEEE. Дои:10.1109 / iccv.2011.6126471. ISBN 978-1-4577-1102-2.

- ^ Ма, Тяньян; Латецкий, Лонгин Ян. Клики максимального веса с ограничениями мьютекса для сегментации видеообъектов. IEEE CVPR 2012 г.. Дои:10.1109 / CVPR.2012.6247735.

- ^ Ван, Ле; Lv, Xin; Чжан, Цилинь; Ню, Чжэньсин; Чжэн, Наньнин; Хуа, банда (2020). «Сосегментация объектов в зашумленных видео с многоуровневым гиперграфом» (PDF). Транзакции IEEE в мультимедиа. IEEE: 1. Дои:10.1109 / тмм.2020.2995266. ISSN 1520-9210.

- ^ а б c Ван, Ле; Дуань, Сюйхуань; Чжан, Цилинь; Ню, Чжэньсин; Хуа, банда; Чжэн, Наньнин (22.05.2018). «Сегмент-трубка: пространственно-временная локализация действия в видео без обрезки с покадровой сегментацией» (PDF). Датчики. MDPI AG. 18 (5): 1657. Дои:10,3390 / с18051657. ISSN 1424-8220. ЧВК 5982167. PMID 29789447.

Материал был скопирован из этого источника, который доступен под Международная лицензия Creative Commons Attribution 4.0.

Материал был скопирован из этого источника, который доступен под Международная лицензия Creative Commons Attribution 4.0.