Принцип ортогональности - Orthogonality principle

В статистика и обработка сигналов, то принцип ортогональности является необходимым и достаточным условием оптимальности Байесовская оценка. В общих чертах принцип ортогональности говорит, что вектор ошибок оптимальной оценки (в среднеквадратичная ошибка смысл) ортогонален любой возможной оценке. Принцип ортогональности чаще всего формулируется для линейных оценок, но возможны и более общие формулировки. Поскольку принцип является необходимым и достаточным условием оптимальности, его можно использовать для нахождения минимальная среднеквадратичная ошибка оценщик.

Принцип ортогональности для линейных оценок

Принцип ортогональности чаще всего используется при линейной оценке.[1] В этом контексте пусть Икс быть неизвестным случайный вектор который должен быть оценен на основе вектора наблюдения у. Хочется построить линейную оценку для какой-то матрицы ЧАС и вектор c. Тогда принцип ортогональности гласит, что оценка достигает минимальная среднеквадратичная ошибка если и только если

- и

Если Икс и у имеют нулевое среднее значение, тогда достаточно потребовать первого условия.

Пример

Предполагать Икс это Гауссовская случайная величина со средним м и дисперсия Также предположим, что мы наблюдаем значение куда ш гауссов шум, не зависящий от Икс и имеет среднее значение 0 и дисперсию Мы хотим найти линейную оценку минимизация MSE. Подставляя выражение в два требования принципа ортогональности, получаем

и

Решая эти два линейных уравнения относительно час и c приводит к

так что линейная оценка минимальной среднеквадратичной ошибки задается

Эту оценку можно интерпретировать как средневзвешенное значение измерений зашумленных измерений. у и предыдущее ожидаемое значение м. Если дисперсия шума низка по сравнению с дисперсией предыдущего (соответствует высокому SNR ), то большая часть веса приходится на измерения у, которые считаются более надежными, чем предыдущая информация. И наоборот, если дисперсия шума относительно выше, то оценка будет близка к м, поскольку измерения недостаточно надежны, чтобы перевесить предварительную информацию.

Наконец, обратите внимание, что поскольку переменные Икс и у вместе являются гауссовыми, оценка минимальной MSE линейна.[2] Следовательно, в этом случае описанный выше оценщик минимизирует MSE среди всех оценщиков, а не только для линейных оценщиков.

Общая формулировка

Позволять быть Гильбертово пространство случайных величин с внутренний продукт определяется . Предполагать это закрыто подпространство , представляющий пространство всех возможных оценок. Хочется найти вектор который аппроксимирует вектор . Точнее, хотелось бы минимизировать среднеквадратичную ошибку (MSE). между и .

В частном случае линейных оценок, описанном выше, пространство это набор всех функций и , пока - множество линейных оценок, т. е. линейных функций от Только. Другие параметры, которые можно сформулировать таким образом, включают подпространство причинный линейные фильтры и подпространство всех (возможно, нелинейных) оценок.

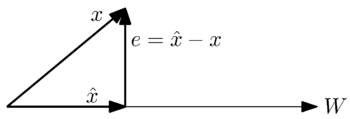

Геометрически мы можем увидеть эту проблему в следующем простом случае, когда это одномерный подпространство:

Мы хотим найти наиболее близкое приближение к вектору вектором в пространстве . Из геометрической интерпретации интуитивно понятно, что наилучшее приближение или наименьшая ошибка возникает, когда вектор ошибки , ортогональна векторам в пространстве .

Точнее, общий принцип ортогональности утверждает следующее: для замкнутого подпространства оценок в гильбертовом пространстве и элемент в , элемент достигает минимальной MSE среди всех элементов в если и только если для всех

Сформулированный таким образом, этот принцип является просто утверждением Теорема проекции Гильберта. Тем не менее, широкое использование этого результата в обработке сигналов привело к названию «принцип ортогональности».

Решение проблем минимизации ошибок

Ниже приводится один из способов найти минимальная среднеквадратичная ошибка оценка с использованием принципа ортогональности.

Мы хотим иметь возможность аппроксимировать вектор к

куда

это приближение как линейная комбинация векторов из подпространства охватывает Поэтому мы хотим иметь возможность найти коэффициенты, , так что мы можем записать наше приближение в известных терминах.

По теореме ортогональности квадратная норма вектора ошибки, , минимизируется, когда для всех j,

Развивая это уравнение, получаем

Если есть конечное число векторов , можно записать это уравнение в матричной форме как

Если предположить находятся линейно независимый, то Матрица грамиана можно инвертировать, чтобы получить

таким образом давая выражение для коэффициентов оценщика минимальной среднеквадратичной ошибки.

Смотрите также

Примечания

- ^ Кей, стр.386

- ^ См. Статью минимальная среднеквадратичная ошибка.

Рекомендации

- Кей, С. М. (1993). Основы статистической обработки сигналов: теория оценивания. Прентис Холл. ISBN 0-13-042268-1.

- Луна, Тодд К. (2000). Математические методы и алгоритмы обработки сигналов.. Прентис-Холл. ISBN 0-201-36186-8.