Балансировка нагрузки (вычисления) - Load balancing (computing)

В вычисление, балансировки нагрузки относится к процессу распространения набора задачи над набором Ресурсы (вычислительные блоки), чтобы сделать их общую обработку более эффективной. Методы балансировки нагрузки позволяют оптимизировать время отклика для каждой задачи, избегая неравномерной перегрузки вычислительных узлов, в то время как другие вычислительные узлы остаются простаивающими.

Балансировка нагрузки является предметом исследований в области параллельные компьютеры. Существуют два основных подхода: статические алгоритмы, которые не принимают во внимание состояние различных машин, и динамические алгоритмы, которые обычно являются более общими и более эффективными, но требуют обмена информацией между различными вычислительными блоками с риском возникновения потеря эффективности.

Обзор проблемы

Алгоритм балансировки нагрузки всегда пытается решить конкретную проблему. Помимо прочего, характер задач, алгоритмический сложность, аппаратная архитектура, на которой будут работать алгоритмы, а также требуемая устойчивость к ошибкам, необходимо учитывать. Поэтому необходимо найти компромисс, чтобы наилучшим образом удовлетворить требования конкретного приложения.

Характер задач

Эффективность алгоритмов балансировки нагрузки критически зависит от характера задач. Следовательно, чем больше информации о задачах доступно на момент принятия решения, тем больше потенциал для оптимизации.

Размер задач

Прекрасное знание время исполнения каждой из задач позволяет достичь оптимального распределения нагрузки (см. алгоритм сумма префикса ).[1] К сожалению, это на самом деле идеализированный случай. Зная точное время исполнения каждой задачи - крайне редкая ситуация.

По этой причине есть несколько способов получить представление о разном времени выполнения. Прежде всего, при удачном сценарии наличия задач относительно однородного размера можно считать, что каждая из них потребует приблизительно среднего времени выполнения. Если, с другой стороны, время выполнения очень нерегулярное, необходимо использовать более сложные методы. Один из способов - добавить немного метаданные к каждой задаче. В зависимости от предыдущего времени выполнения аналогичных метаданных можно сделать выводы для будущей задачи на основе статистики.[2]

Зависимости

В некоторых случаях задачи зависят друг от друга. Эти взаимозависимости можно проиллюстрировать ориентированный ациклический граф. Интуитивно понятно, что некоторые задачи не могут начаться, пока другие не будут выполнены.

Предполагая, что необходимое время для каждой из задач известно заранее, оптимальный порядок выполнения должен привести к минимизации общего времени выполнения. Хотя это NP-жесткий проблема и поэтому может быть трудно решить точно. Есть алгоритмы вроде планировщик заданий, которые вычисляют оптимальные распределения задач, используя метаэвристический методы.

Разделение задач

Еще одна особенность задач, критически важных для разработки алгоритма балансировки нагрузки, - это их способность разбиваться на подзадачи во время выполнения. Алгоритм «древовидных вычислений», представленный ниже, в значительной степени использует эту особенность.

Статические и динамические алгоритмы

Статический

Алгоритм балансировки нагрузки является «статическим», когда он не принимает во внимание состояние системы для распределения задач. Таким образом, состояние системы включает такие меры, как уровень нагрузки (а иногда и перегрузка) некоторых процессоров. Вместо этого заранее делаются предположения для всей системы, такие как время прибытия и потребности в ресурсах входящих задач. Кроме того, известно количество процессоров, их мощность и скорость передачи данных. Следовательно, статическая балансировка нагрузки направлена на то, чтобы связать известный набор задач с доступными процессорами, чтобы минимизировать определенную функцию производительности. Уловка заключается в самой концепции этой функции производительности.

Методы статической балансировки нагрузки обычно централизованы вокруг маршрутизатора или Мастер, который распределяет нагрузки и оптимизирует функцию производительности. Эта минимизация может учитывать информацию, относящуюся к задачам, которые должны быть распределены, и определять ожидаемое время выполнения.

Преимущество статических алгоритмов в том, что их легко настроить и они чрезвычайно эффективны в случае довольно регулярных задач (например, обработка HTTP-запросов с веб-сайта). Однако по-прежнему существует некоторая статистическая разница в распределении задач, которая может привести к перегрузке некоторых вычислительных устройств.

Динамический

В отличие от алгоритмов статического распределения нагрузки, динамические алгоритмы учитывают текущую нагрузку каждого из вычислительных блоков (также называемых узлами) в системе. При таком подходе задачи можно динамически перемещать с перегруженного узла на недогруженный, чтобы получить более быструю обработку. Хотя эти алгоритмы намного сложнее разработать, они могут дать отличные результаты, в частности, когда время выполнения сильно варьируется от одной задачи к другой.

При динамической балансировке нагрузки архитектура может быть больше модульный поскольку не обязательно иметь конкретный узел, выделенный для распределения работы. Когда задачи однозначно назначаются процессору в соответствии с его состоянием в данный момент, это уникальное назначение. Если, с другой стороны, задачи могут быть постоянно перераспределены в соответствии с состоянием системы и ее развитием, это называется динамическим назначением. [3]. Очевидно, что алгоритм балансировки нагрузки, который требует слишком много коммуникаций для принятия решений, рискует замедлить решение общей проблемы.

Аппаратная архитектура

Гетерогенные машины

Инфраструктуры параллельных вычислений часто состоят из блоков разных вычислительная мощность, что необходимо учитывать при распределении нагрузки.

Например, блоки с меньшей мощностью могут получать запросы, требующие меньшего объема вычислений, или, в случае однородных или неизвестных размеров запросов, получать меньше запросов, чем блоки большего размера.

Параллельные компьютеры часто делятся на две большие категории: те, в которых все процессоры используют одну общую память, в которой они читают и записывают параллельно (PRAM модель), и те, в которых каждый вычислительный блок имеет свою память (распределенная память модель), и где информация обменивается сообщениями.

Для Общая память компьютеры, управляющие конфликтами записи, значительно замедляют скорость индивидуального выполнения каждого вычислительного блока. Однако они могут прекрасно работать параллельно. И наоборот, в случае обмена сообщениями каждый из процессоров может работать на полной скорости. С другой стороны, когда дело доходит до коллективного обмена сообщениями, все процессоры вынуждены ждать, пока самые медленные процессоры начнут фазу связи.

На самом деле, немногие системы попадают точно в одну из категорий. Как правило, каждый процессор имеет внутреннюю память для хранения данных, необходимых для следующих вычислений, и организован в последовательную кластеры. Часто эти элементы обработки затем координируются посредством распределенной памяти и передачи сообщений. Следовательно, алгоритм балансировки нагрузки должен быть однозначно адаптирован к параллельной архитектуре. В противном случае есть риск, что эффективность параллельного решения задач сильно снизится.

Иерархия

В зависимости от структуры оборудования, показанной выше, можно выделить две основные категории алгоритмов балансировки нагрузки. С одной стороны, та, где задачи назначаются «мастером» и выполняются «работниками», которые информируют мастера о ходе своей работы, а мастер может затем взять на себя назначение или переназначение рабочей нагрузки в случае динамической алгоритм. В литературе это называется «Мастер-рабочий» архитектура. С другой стороны, управление может быть распределено между разными узлами. Затем алгоритм балансировки нагрузки выполняется на каждом из них, и ответственность за назначение задач (а также, при необходимости, переназначение и разделение) разделяется. Последняя категория предполагает алгоритм динамической балансировки нагрузки.

Поскольку дизайн каждого алгоритма балансировки нагрузки уникален, предыдущее различие должно быть оговорено. Таким образом, также возможно иметь промежуточную стратегию, например, с «главными» узлами для каждого подкластера, которые сами подчиняются глобальному «главному». Существуют также многоуровневые организации с чередованием стратегий управления ведущий-ведомый и распределенного управления. Последние стратегии быстро усложняются и встречаются редко. Дизайнеры предпочитают алгоритмы, которыми легче управлять.

Адаптация к более крупным архитектурам (масштабируемость)

В контексте алгоритмов, которые работают в течение очень длительного времени (серверы, облако ...), компьютерная архитектура со временем развивается. Однако желательно не создавать каждый раз новый алгоритм.

Поэтому чрезвычайно важным параметром алгоритма балансировки нагрузки является его способность адаптироваться к масштабируемой аппаратной архитектуре. Это называется масштабируемость алгоритма. Алгоритм называется масштабируемым для входного параметра, если его производительность остается относительно независимой от размера этого параметра.

Когда алгоритм может адаптироваться к изменяющемуся количеству вычислительных блоков, но количество вычислительных блоков должно быть зафиксировано перед выполнением, он называется изменяемым. Если, с другой стороны, алгоритм может иметь дело с колеблющимся количеством процессоров во время своего выполнения, говорят, что алгоритм податлив. Большинство алгоритмов балансировки нагрузки, по крайней мере, можно формулировать. [4].

Отказоустойчивость

Особенно в крупных вычислительные кластеры, недопустимо выполнение параллельного алгоритма, который не может выдержать отказ одного отдельного компонента. Следовательно, отказоустойчивой разрабатываются алгоритмы, которые могут обнаруживать сбои процессоров и восстанавливать вычисления.[5]

Подходы

Статическая раздача с полным знанием задач: сумма префикса

Если задачи независимы друг от друга и если время их выполнения и задачи можно разделить, существует простой и оптимальный алгоритм.

Разделив задачи таким образом, чтобы предоставить каждому процессору одинаковый объем вычислений, все, что остается сделать, - это сгруппировать результаты вместе. С помощью сумма префикса алгоритма, это деление может быть вычислено в логарифмическое время по количеству процессоров.

Однако, если задачи не могут быть разделены (т. Е. Они являются атомарными), хотя оптимизация назначения задач является сложной задачей, все же возможно приблизить относительно справедливое распределение задач, при условии, что размер каждой из них намного меньше, чем общий объем вычислений, выполняемых каждым из узлов.[6]

В большинстве случаев время выполнения задачи неизвестно, и доступны только приблизительные значения. Этот алгоритм, хотя и особенно эффективен, в этих сценариях неприменим.

Распределение статической нагрузки без предварительного знания

Даже если время выполнения заранее не известно, статическое распределение нагрузки всегда возможно.

По-круговой

В этом простом алгоритме первый запрос отправляется первому серверу, затем следующий - второму и так далее до последнего. Затем он запускается снова, присваивая следующий запрос первому серверу и так далее.

Этот алгоритм можно взвесить так, чтобы самые мощные блоки получали наибольшее количество запросов и получали их первыми.

Рандомизированный статический

Рандомизированная статическая балансировка нагрузки - это просто случайное назначение задач различным серверам. Этот метод работает достаточно хорошо. Если, с другой стороны, количество задач известно заранее, еще более эффективно заранее вычислить случайную перестановку. Это позволяет избежать затрат на связь для каждого задания. Больше нет необходимости в мастере распределения, потому что каждый знает, какая задача ему поручена. Даже если количество задач неизвестно, все же можно избежать взаимодействия с генерацией псевдослучайного назначения, известной всем процессорам.

Производительность этой стратегии (измеренная в общем времени выполнения для данного фиксированного набора задач) снижается с увеличением максимального размера задач.

Другие

Конечно, есть и другие способы присвоения:

- Меньше работы: назначайте серверам больше задач, выполняя меньше (метод также может быть взвешенным).

- Хеш: распределяет запросы в соответствии с хеш-таблица.

- Сила двух вариантов: выберите два сервера наугад и выберите лучший из двух вариантов.[7][8]

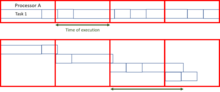

Схема мастер-рабочий

Мастер-рабочий схемы являются одними из самых простых алгоритмов динамической балансировки нагрузки. Мастер распределяет рабочую нагрузку между всеми работниками (также иногда называемыми «подчиненными»). Изначально все рабочие простаивают и сообщают об этом мастеру. Мастер отвечает на запросы работников и раздает им задания. Когда у него больше нет задач, он информирует рабочих, чтобы они перестали просить о задачах.

Преимущество этой системы в том, что она распределяет нагрузку очень справедливо. Фактически, если не принимать во внимание время, необходимое для назначения, время выполнения будет сопоставимо с суммой префиксов, показанной выше.

Проблема этого алгоритма в том, что его трудно адаптировать к большому количеству процессоров из-за большого количества необходимых коммуникаций. Это отсутствие масштабируемость делает его быстро неработоспособным на очень больших серверах или очень больших параллельных компьютерах. Мастер действует как горлышко бутылки.

Однако качество алгоритма можно значительно улучшить, заменив мастер списком задач, который может использоваться разными процессорами. Хотя этот алгоритм немного сложнее реализовать, он обещает гораздо лучшую масштабируемость, хотя все еще недостаточную для очень крупных вычислительных центров.

Неиерархическая архитектура без знания системы: работа воровство

Другой метод решения проблем масштабируемости, когда время, необходимое для выполнения задачи, неизвестно, - это работа воровство.

Подход состоит в назначении каждому процессору определенного количества задач случайным или заранее определенным образом, а затем позволяет неактивным процессорам «красть» работу у активных или перегруженных процессоров. Существует несколько реализаций этой концепции, определяемых моделью разделения задач и правилами, определяющими обмен между процессорами. Хотя этот метод может быть особенно эффективным, его трудно реализовать, поскольку необходимо гарантировать, что обмен данными не станет основным занятием процессоров вместо решения проблемы.

В случае атомарных задач можно выделить две основные стратегии: те, где процессоры с низкой нагрузкой предлагают свои вычислительные мощности тем, у кого самая высокая нагрузка, и те, где наиболее загруженные блоки хотят облегчить назначенную им рабочую нагрузку. Было показано[9] что, когда сеть сильно загружена, для наименее загруженных устройств более эффективно предлагать свою доступность, а когда сеть слабо загружена, именно перегруженные процессоры требуют поддержки со стороны наиболее неактивных. Это практическое правило ограничивает количество сообщений, которыми обмениваются.

В случае, когда кто-то начинает с одной большой задачи, которую нельзя разделить за пределы атомарного уровня, существует очень эффективный алгоритм «Древовидные вычисления».[10], где родительская задача распределяется в дереве работ.

Принцип

Изначально у многих процессоров есть пустая задача, кроме той, которая последовательно работает над ней. Неактивные процессоры отправляют запросы другим процессорам (не обязательно активным) случайным образом. Если последний может разделить задачу, над которой он работает, он делает это, отправляя часть своей работы узлу, выполняющему запрос. В противном случае возвращается пустая задача. Это вызывает древовидную структуру. Затем необходимо отправить сигнал завершения родительскому процессору, когда подзадача завершена, чтобы он, в свою очередь, отправлял сообщение своему родительскому процессору, пока не достигнет корня дерева. Когда первый процессор, то есть корень, завершит работу, может быть передано глобальное сообщение о завершении. В конце необходимо собрать результаты, вернувшись вверх по дереву.

Эффективность

Эффективность такого алгоритма близка к сумме префиксов, когда время нарезки работы и коммуникации не слишком велико по сравнению с работой, которую нужно сделать. Чтобы избежать слишком высоких затрат на связь, можно представить список заданий в общей памяти. Следовательно, запрос - это просто чтение из определенной позиции в этой разделяемой памяти по запросу главного процессора.

заявка

Помимо эффективного решения проблем с помощью параллельных вычислений, алгоритмы балансировки нагрузки широко используются в управлении HTTP-запросами, когда сайт с большой аудиторией должен иметь возможность обрабатывать запросы в секунду.

Интернет-сервисы

В этом разделе несколько вопросов. Пожалуйста помоги Улучши это или обсудите эти вопросы на страница обсуждения. (Узнайте, как и когда удалить эти сообщения-шаблоны) (Узнайте, как и когда удалить этот шаблон сообщения)

|

Одним из наиболее часто используемых приложений балансировки нагрузки является предоставление одной интернет-услуги из нескольких серверы, иногда известный как ферма серверов. Обычно системы с балансировкой нагрузки включают популярные веб-сайты, большой Интернет-чат сети, высокая пропускная способность протокол передачи файлов места, Протокол передачи сетевых новостей (NNTP) серверы, система доменных имен (DNS) серверы и базы данных.

Циклический DNS

Альтернативный метод балансировки нагрузки, который не требует выделенного программного или аппаратного узла, называется циклический DNS. В этой технике несколько IP-адреса связаны с одним доменное имя; клиентам предоставляется IP-адрес в циклическом порядке. IP назначается клиентам с коротким сроком действия, поэтому клиент с большей вероятностью будет использовать другой IP-адрес при следующем доступе к запрашиваемой интернет-службе.

Делегирование DNS

Еще один более эффективный метод балансировки нагрузки с использованием DNS - делегирование www.example.org как субдомен, зона которого обслуживается каждым из тех же серверов, которые обслуживают веб-сайт. Этот метод особенно хорошо работает, когда отдельные серверы географически распределены в Интернете. Например:

one.example.org A 192.0.2.1two.example.org A 203.0.113.2www.example.org NS one.example.orgwww.example.org NS two.example.org

Однако файл зоны для www.example.org на каждом сервере разные, так что каждый сервер разрешает свой собственный IP-адрес как A-запись.[11] На сервере один файл зоны для www.example.org отчеты:

@ в 192.0.2.1

На сервере два тот же файл зоны содержит:

@ в 203.0.113.2

Таким образом, когда сервер не работает, его DNS не отвечает, и веб-служба не получает никакого трафика. Если линия к одному серверу перегружена, ненадежность DNS гарантирует, что меньше HTTP-трафика достигает этого сервера. Кроме того, самый быстрый ответ DNS на преобразователь почти всегда - это ответ ближайшего к сети сервера, что обеспечивает географическую балансировку нагрузки.[нужна цитата ]. Короче TTL на A-записи помогает обеспечить быстрое переключение трафика при выходе из строя сервера. Следует учитывать возможность того, что этот метод может вызвать переключение отдельных клиентов между отдельными серверами в середине сеанса.

Случайная балансировка нагрузки на стороне клиента

Другой подход к балансировке нагрузки состоит в том, чтобы доставить клиенту список IP-адресов серверов, а затем позволить клиенту случайным образом выбирать IP-адрес из списка для каждого соединения.[12][13] По сути, это зависит от всех клиентов, генерирующих одинаковые нагрузки, и Закон больших чисел[13] для достижения достаточно равномерного распределения нагрузки между серверами. Было заявлено, что случайная балансировка нагрузки на стороне клиента, как правило, обеспечивает лучшее распределение нагрузки, чем циклический DNS; это было связано с проблемами кэширования в DNS с циклическим перебором, которые в случае больших серверов кэширования DNS имеют тенденцию искажать распределение для DNS с циклическим перебором, в то время как случайный выбор на стороне клиента остается неизменным независимо от кэширования DNS.[13]

При таком подходе метод доставки списка IP-адресов клиенту может варьироваться и может быть реализован как список DNS (доставляется всем клиентам без циклического перебора) или путем жесткого кодирования его в список. Если используется «умный клиент», который обнаруживает, что случайно выбранный сервер не работает и снова случайным образом подключается, он также обеспечивает отказоустойчивость.

Балансировщики нагрузки на стороне сервера

Для Интернет-служб балансировщик нагрузки на стороне сервера обычно представляет собой программу, которая прослушивает порт где внешние клиенты подключаются к службам доступа. Балансировщик нагрузки перенаправляет запросы на один из «внутренних» серверов, который обычно отвечает на балансировщик нагрузки. Это позволяет балансировщику нагрузки отвечать клиенту, даже не зная о внутреннем разделении функций. Он также не позволяет клиентам напрямую связываться с внутренними серверами, что может иметь преимущества в плане безопасности за счет сокрытия структуры внутренней сети и предотвращения атак на сетевой стек ядра или несвязанные службы, работающие на других портах.

Некоторые подсистемы балансировки нагрузки предоставляют механизм для выполнения чего-то особенного в случае, если все внутренние серверы недоступны. Это может включать переадресацию на резервный подсистему балансировки нагрузки или отображение сообщения о сбое.

Также важно, чтобы балансировщик нагрузки сам по себе не становился единая точка отказа. Обычно балансировщики нагрузки реализуются в высокая доступность пары, которые также могут реплицировать данные о сохранении сеанса, если этого требует конкретное приложение.[14] Некоторые приложения запрограммированы с невосприимчивостью к этой проблеме, смещая точку балансировки нагрузки по разным платформам совместного использования за пределами определенной сети. Последовательные алгоритмы, связанные с этими функциями, определяются гибкими параметрами, уникальными для конкретной базы данных.[15]

Алгоритмы планирования

Многочисленные алгоритмы планирования, также называемые методами балансировки нагрузки, используются подсистемами балансировки нагрузки для определения того, на какой внутренний сервер отправить запрос. Простые алгоритмы включают случайный выбор, по-круговой, или минимум связей.[16] Более сложные балансировщики нагрузки могут учитывать дополнительные факторы, такие как заявленная нагрузка сервера, наименьшее время отклика, состояние включения / выключения (определяемое каким-либо опросом мониторинга), количество активных подключений, географическое положение, возможности или количество трафик он был недавно назначен.

Упорство

Важным вопросом при работе службы с балансировкой нагрузки является то, как обрабатывать информацию, которая должна храниться в нескольких запросах в сеансе пользователя. Если эта информация хранится локально на одном внутреннем сервере, то последующие запросы, идущие к другим внутренним серверам, не смогут ее найти. Это может быть кэшированная информация, которую можно пересчитать, и в этом случае балансировка нагрузки запроса к другому внутреннему серверу просто создает проблемы с производительностью.[16]

В идеале кластер серверов за балансировщиком нагрузки не должен поддерживать сеанс, так что если клиент подключается к любому внутреннему серверу в любое время, взаимодействие с пользователем не пострадает. Обычно это достигается с помощью общей базы данных или базы данных сеанса в памяти, например Memcached.

Одним из основных решений проблемы данных сеанса является последовательная отправка всех запросов в пользовательском сеансе на один и тот же внутренний сервер. Это известно как «настойчивость» или «липкость». Существенным недостатком этого метода является отсутствие автоматического аварийное переключение: если внутренний сервер выходит из строя, его информация о сеансе становится недоступной, и любые сеансы, зависящие от него, теряются. Та же проблема обычно актуальна для центральных серверов баз данных; даже если веб-серверы «не имеют состояния», а не «липкие», центральная база данных остается (см. ниже).

Назначение конкретному серверу может быть основано на имени пользователя, IP-адресе клиента или быть случайным. Из-за изменений воспринимаемого адреса клиента в результате DHCP, преобразование сетевых адресов, и веб-прокси этот метод может быть ненадежным. Балансировщик нагрузки должен запоминать случайные назначения, что создает нагрузку на хранилище. Если балансировщик нагрузки заменяется или выходит из строя, эта информация может быть потеряна, и назначения, возможно, потребуется удалить после периода ожидания или в периоды высокой нагрузки, чтобы избежать превышения пространства, доступного для таблицы назначений. Метод случайного назначения также требует, чтобы клиенты поддерживали некоторое состояние, что может быть проблемой, например, когда веб-браузер отключил хранение файлов cookie. Сложные балансировщики нагрузки используют несколько методов сохранения, чтобы избежать некоторых недостатков любого одного метода.

Другое решение - хранить данные сеанса в база данных. Как правило, это плохо сказывается на производительности, поскольку увеличивает нагрузку на базу данных: базу данных лучше всего использовать для хранения информации, менее преходящей, чем данные за сеанс. Чтобы база данных не стала единая точка отказа, и улучшить масштабируемость, база данных часто реплицируется на несколько компьютеров, а балансировка нагрузки используется для распределения нагрузки запросов по этим репликам. Microsoft с ASP.net Технология State Server является примером сеансовой базы данных.Все серверы в веб-ферме хранят данные своих сеансов на сервере состояний, и любой сервер в ферме может получать эти данные.

В очень распространенном случае, когда клиентом является веб-браузер, простой, но эффективный подход состоит в том, чтобы хранить данные сеанса в самом браузере. Один из способов добиться этого - использовать cookie браузера, с соответствующей отметкой времени и зашифрованным. Другой Перезапись URL. Обычно предпочтительным решением является хранение данных сеанса на клиенте: тогда балансировщик нагрузки может выбрать любой внутренний сервер для обработки запроса. Однако этот метод обработки данных о состоянии плохо подходит для некоторых сложных сценариев бизнес-логики, когда полезная нагрузка состояния сеанса велика и пересчитывать ее с каждым запросом на сервере невозможно. Перезапись URL имеет серьезные проблемы с безопасностью, поскольку конечный пользователь может легко изменить отправленный URL и, таким образом, изменить потоки сеанса.

Еще одно решение для хранения постоянных данных - связать имя с каждым блоком данных и использовать распределенная хеш-таблица для псевдослучайного присвоения этого имени одному из доступных серверов, а затем сохранения этого блока данных на назначенном сервере.

Функции балансировщика нагрузки

Аппаратные и программные балансировщики нагрузки могут иметь множество специальных функций. Фундаментальная особенность балансировщика нагрузки - это возможность распределять входящие запросы по ряду внутренних серверов в кластере в соответствии с алгоритмом планирования. Большинство из следующих функций зависят от производителя:

- Асимметричная нагрузка

- Соотношение может быть назначено вручную, чтобы некоторые серверные серверы получали большую долю рабочей нагрузки, чем другие. Иногда это используется как грубый способ учесть некоторые серверы, имеющие большую емкость, чем другие, и не всегда могут работать должным образом.

- Приоритетная активация

- Когда количество доступных серверов падает ниже определенного числа или нагрузка становится слишком высокой, резервные серверы могут быть переведены в оперативный режим.

- Разгрузка и ускорение TLS

- Ускорение TLS (или его предшественника SSL) - это метод передачи вычислений криптографического протокола на специализированное оборудование. В зависимости от рабочей нагрузки обработка требований к шифрованию и аутентификации TLS запрос может стать основной частью нагрузки на ЦП веб-сервера; по мере увеличения спроса пользователи будут видеть более медленное время отклика, поскольку накладные расходы TLS распределяются между веб-серверами. Чтобы устранить эту потребность на веб-серверах, балансировщик может разрывать соединения TLS, передавая запросы HTTPS как запросы HTTP на веб-серверы. Если сам балансировщик не перегружен, это не приведет к заметному снижению производительности, воспринимаемой конечными пользователями. Обратной стороной этого подхода является то, что вся обработка TLS сосредоточена на одном устройстве (балансировщике), которое может стать новым узким местом. Некоторые устройства балансировки нагрузки включают специализированное оборудование для обработки TLS. Вместо обновления балансировщика нагрузки, который представляет собой довольно дорогое выделенное оборудование, может быть дешевле отказаться от разгрузки TLS и добавить несколько веб-серверов. Кроме того, некоторые поставщики серверов, такие как Oracle / Sun, теперь включают оборудование для криптографического ускорения в свои процессоры, такие как T2000. F5 Networks включает выделенную аппаратную карту ускорения TLS в свой локальный диспетчер трафика (LTM), который используется для шифрования и дешифрования трафика TLS. Одно очевидное преимущество разгрузки TLS в балансировщике заключается в том, что он позволяет ему выполнять балансировку или переключение контента на основе данных в запросе HTTPS.

- Распределенный отказ в обслуживании (DDoS) защита от атак

- Балансировщики нагрузки могут предоставлять такие функции, как SYN файлы cookie и отложенное связывание (внутренние серверы не видят клиента, пока он не завершит свое TCP-рукопожатие), чтобы смягчить SYN флуд атакуют и обычно переносят работу с серверов на более эффективную платформу.

- HTTP-сжатие

- Сжатие HTTP уменьшает объем данных, передаваемых для объектов HTTP, за счет использования сжатия gzip, доступного во всех современных веб-браузерах. Чем больше отклик и чем дальше находится клиент, тем больше эта функция может сократить время отклика. Компромисс заключается в том, что эта функция вызывает дополнительную нагрузку на ЦП балансировщика нагрузки и вместо этого может выполняться веб-серверами.

- Разгрузка TCP

- Разные поставщики используют разные термины для этого, но идея состоит в том, что обычно каждый HTTP-запрос от каждого клиента представляет собой отдельное TCP-соединение. Эта функция использует HTTP / 1.1 для объединения нескольких HTTP-запросов от нескольких клиентов в один TCP-сокет к внутренним серверам.

- Буферизация TCP

- Балансировщик нагрузки может буферизовать ответы сервера и выдавать данные медленным клиентам, позволяя веб-серверу освобождать поток для других задач быстрее, чем если бы он отправлял весь запрос клиенту напрямую.

- Прямой возврат сервера

- Вариант асимметричного распределения нагрузки, когда у запроса и ответа разные сетевые пути.

- Проверка здоровья

- Балансировщик опрашивает серверы на предмет работоспособности уровня приложений и удаляет отказавшие серверы из пула.

- HTTP-кеширование

- Балансировщик хранит статический контент, поэтому некоторые запросы можно обрабатывать без обращения к серверам.

- Фильтрация контента

- Некоторые балансировщики могут произвольно изменять проходящий трафик.

- Безопасность HTTP

- Некоторые балансировщики могут скрывать страницы ошибок HTTP, удалять заголовки идентификации сервера из ответов HTTP и шифровать файлы cookie, чтобы конечные пользователи не могли ими манипулировать.

- Приоритетная очередь

- Также известен как формирование ставок, возможность давать разный приоритет разному трафику.

- Переключение с учетом содержимого

- Большинство балансировщиков нагрузки могут отправлять запросы на разные серверы в зависимости от запрашиваемого URL-адреса, при условии, что запрос не зашифрован (HTTP) или, если он зашифрован (через HTTPS), запрос HTTPS завершается (расшифровывается) в балансировщике нагрузки.

- Проверка подлинности клиента

- Аутентифицируйте пользователей с помощью различных источников аутентификации, прежде чем разрешить им доступ к веб-сайту.

- Программное управление трафиком

- По крайней мере, один балансировщик позволяет использовать язык сценариев, позволяющий настраивать методы балансировки, произвольные манипуляции с трафиком и многое другое.

- Брандмауэр

- Брандмауэры могут препятствовать прямым подключениям к внутренним серверам по соображениям безопасности сети.

- Система предотвращения вторжений

- Системы предотвращения вторжений предлагают безопасность на уровне приложений в дополнение к сетевому / транспортному уровню, предлагаемому защитой межсетевого экрана.

Использование в телекоммуникациях

Балансировка нагрузки может быть полезна в приложениях с избыточными каналами связи. Например, у компании может быть несколько подключений к Интернету, обеспечивающих доступ к сети в случае сбоя одного из подключений. А аварийное переключение расположение будет означать, что одна ссылка предназначена для нормального использования, а вторая ссылка используется только в случае отказа основного канала.

Используя балансировку нагрузки, обе ссылки могут использоваться все время. Устройство или программа отслеживает доступность всех ссылок и выбирает путь для отправки пакетов. Использование нескольких каналов одновременно увеличивает доступную пропускную способность.

Кратчайший путь моста

IEEE одобрил IEEE 802.1aq стандарт май 2012,[17] также известный как мост по кратчайшему пути (SPB). SPB позволяет всем каналам быть активными через несколько путей с одинаковой стоимостью, обеспечивает более быстрое время конвергенции для сокращения времени простоя и упрощает использование балансировки нагрузки в топологии ячеистой сети (частично и / или полностью), позволяя трафику распределять нагрузку по всем путям сети.[18][19] SPB разработан для того, чтобы практически исключить человеческую ошибку во время настройки и сохраняет принцип plug-and-play, который установил Ethernet как фактический протокол на уровне 2.[20]

Маршрут 1

Многие телекоммуникационные компании используют несколько маршрутов через свои сети или к внешним сетям. Они используют сложную балансировку нагрузки для переключения трафика с одного пути на другой, чтобы избежать перегрузка сети по любому конкретному каналу, а иногда и для минимизации стоимости транзита по внешним сетям или улучшения надежность сети.

Другой способ использования балансировки нагрузки - сетевой мониторинг деятельность. Балансировщики нагрузки можно использовать для разделения огромных потоков данных на несколько подпотоков и использования нескольких сетевых анализаторов, каждый из которых считывает часть исходных данных. Это очень полезно для мониторинга быстрых сетей, таких как 10GbE или STM64, где сложная обработка данных может быть невозможна на скорость проволоки.[21]

Использование в сетях центров обработки данных

Балансировка нагрузки широко используется в сетях центров обработки данных для распределения трафика по множеству существующих путей между любыми двумя серверами.[22] Это позволяет более эффективно использовать пропускную способность сети и снижает затраты на выделение ресурсов. В целом балансировку нагрузки в сетях центров обработки данных можно разделить на статическую или динамическую. Статическая балансировка нагрузки распределяет трафик, вычисляя хэш адресов источника и назначения и номеров портов потоков трафика и используя его для определения того, как потоки назначаются одному из существующих путей. Динамическая балансировка нагрузки распределяет потоки трафика по путям, отслеживая использование полосы пропускания различных путей. Динамическое назначение также может быть проактивным или реактивным. В первом случае назначение фиксируется после выполнения, а во втором сетевая логика продолжает отслеживать доступные пути и перемещает потоки по ним по мере изменения использования сети (с появлением новых потоков или завершением существующих). Доступен полный обзор балансировки нагрузки в сетях центров обработки данных.[22]

Отношение к отработке отказа

Балансировка нагрузки часто используется для реализации аварийное переключение - продолжение обслуживания после отказа одного или нескольких его компонентов. Компоненты постоянно контролируются (например, веб-серверы могут контролироваться путем получения известных страниц), и когда один из них перестает отвечать, балансировщик нагрузки получает информацию и больше не отправляет ему трафик. Когда компонент возвращается в оперативный режим, балансировщик нагрузки снова начинает направлять ему трафик. Чтобы это работало, должен быть хотя бы один компонент, превышающий возможности службы (N + 1 резервирование ). Это может быть гораздо менее затратным и более гибким, чем подходы к аварийному переключению, когда каждый отдельный активный компонент сопряжен с одним резервным компонентом, который берет на себя ответственность в случае сбоя (двойное модульное резервирование ). Некоторые виды RAID системы также могут использовать горячий запас для аналогичного эффекта.[23]

Смотрите также

- Маска сродства

- Контроллер доставки приложений

- Автомасштабирование

- Облачные вычисления

- Общий протокол резервирования адресов

- Периферийные вычисления

- Туманные вычисления

- Балансировка сетевой нагрузки

- Службы балансировки сетевой нагрузки

- Раздел (база данных)

- Сходство с процессором

- Запись SRV

- Планирование на основе транспозиции

использованная литература

- ^ Сандерс, Питер; Мельхорн, Курт; Дицфельбингер, Мартин; Дементьев, Роман (11 сентября 2019). Последовательные и параллельные алгоритмы и структуры данных: базовый набор инструментов. ISBN 978-3-030-25208-3.

- ^ Лю, Ци; Цай, Вэйдун; Джин, Дандан; Шен, Цзянь; Фу, Чжанцзе; Лю, Сяодун; Линге, Найджел (30 августа 2016 г.). «Точность оценки времени выполнения задач времени выполнения в неоднородной распределенной среде». Датчики. 16 (9): 1386. Дои:10,3390 / с16091386. PMID 27589753. S2CID 391429.

- ^ Алакил, Али (ноябрь 2009 г.). «Руководство по динамической балансировке нагрузки в распределенных компьютерных системах». Международный журнал компьютерных наук и сетевой безопасности (IJCSNS). 10.

- ^ Асгар, Саджад; Обанель, Эрик; Бремнер, Дэвид (октябрь 2013 г.). «Параллельный решатель SAT на основе динамического планирования заданий». 2013 42-я Международная конференция по параллельной обработке: 110–119. Дои:10.1109 / ICPP.2013.20. ISBN 978-0-7695-5117-3. S2CID 15124201.

- ^ Punetha Sarmila, G .; Gnanambigai, N .; Динадаялан, П. (2015). «Обзор отказоустойчивых алгоритмов балансировки нагрузки в облачных вычислениях». 2-я Международная конференция по электронике и системам связи (ICECS): 1715–1720. Дои:10.1109 / ECS.2015.7124879. ISBN 978-1-4799-7225-8. S2CID 30175022.

- ^ Сандерс, Питер; Мельхорн, Курт; Дицфельбингер, Мартин; Дементьев, Роман (11 сентября 2019). Последовательные и параллельные алгоритмы и структуры данных: базовый набор инструментов. ISBN 978-3-030-25208-3.

- ^ "NGINX и" сила двух вариантов "алгоритм балансировки нагрузки". nginx.com. 2018-11-12. Архивировано из оригинал на 2019-12-12.

- ^ «Тест-драйв» Сила двух случайных вариантов «Балансировка нагрузки». haproxy.com. 2019-02-15. Архивировано из оригинал на 2019-02-15.

- ^ Нетерпеливый, Дерек Л. Лазовская, Эдвард Д; Захоржан, Джон (1 марта 1986 г.). «Сравнение инициируемого получателем и отправителя адаптивного распределения нагрузки». Оценка эффективности. 6 (1): 53–68. Дои:10.1016/0166-5316(86)90008-8. ISSN 0166-5316.

- ^ Сандерс, Питер (1998). «Древовидные вычисления как модель для параллельных приложений». Дои:10.5445 / ir / 1000074497. Цитировать журнал требует

| журнал =(Помогите) - ^ Запись адреса IPv4 (A)

- ^ Паттерн: балансировка нагрузки на стороне клиента

- ^ а б c Серверная архитектура MMOG. Серверы переднего плана и случайная балансировка нагрузки на стороне клиента

- ^ "Высокая доступность". linuxvirtualserver.org. Получено 2013-11-20.

- ^ Ранджан, Р. (2010). «Предоставление однорангового облака: обнаружение сервисов и балансировка нагрузки». Облачные вычисления.

- ^ а б «Балансировка нагрузки 101: гайки и болты». F5 Сети. 2017-12-05. Архивировано из оригинал на 2017-12-05. Получено 2018-03-23.

- ^ Шуанг Ю (8 мая 2012 г.). «IEEE УТВЕРЖДАЕТ НОВЫЙ СТАНДАРТ IEEE 802.1aq ™ для кратчайшего пути перехода». IEEE. Получено 2 июн 2012.

- ^ Питер Эшвуд-Смит (24 февраля 2011 г.). "Кратчайший путь моста IEEE 802.1aq Обзор" (PDF). Huawei. Архивировано из оригинал (PDF) 15 мая 2013 г.. Получено 11 мая 2012.

- ^ Джим Даффи (11 мая 2012 г.). «Крупнейшая система здравоохранения Иллинойса искореняет Cisco, чтобы построить частное облако стоимостью 40 миллионов долларов». Советник по ПК. Получено 11 мая 2012.

Мост по кратчайшему пути заменит связующее дерево в структуре Ethernet.

- ^ «IEEE утверждает новый стандарт моста кратчайшего пути IEEE 802.1aq». Технология Power Up. 7 мая 2012. Получено 11 мая 2012.

- ^ Мохаммад Ноормохаммадпур, Колиджи С. Рагхавендра Минимизация времени завершения потока с помощью адаптивной маршрутизации по глобальным сетям между центрами обработки данных Стендовые сессии IEEE INFOCOM 2018, DOI: 10.13140 / RG.2.2.36009.90720 6 января 2019 г.

- ^ а б М. Ноормохаммадпур, К. С. Рагхавендра, «Управление трафиком центра обработки данных: понимание методов и компромиссов», IEEE Communications Surveys & Tutorials, vol. ПП, нет. 99, стр. 1-1.

- ^ Отработка отказа и балансировка нагрузки IBM 6 января 2019 г.