Вероятностная классификация - Probabilistic classification

| Часть серии по |

| Машинное обучение и сбор данных |

|---|

Площадки для машинного обучения |

В машинное обучение, а вероятностный классификатор это классификатор который может предсказать, учитывая наблюдение за входом, распределение вероятностей через набор классов, а не только для вывода наиболее вероятного класса, к которому должно принадлежать наблюдение. Вероятностные классификаторы обеспечивают классификацию, которая может быть полезна сама по себе.[1] или при объединении классификаторов в ансамбли.

Типы классификации

Формально «обычный» классификатор - это какое-то правило, или функция, который назначает образец Икс метка класса ŷ:

Образцы взяты из некоторого набора Икс (например, набор всех документы, или набор всех картинки ), а метки классов образуют конечное множество Y определяется до обучения.

Вероятностные классификаторы обобщают это понятие классификаторов: вместо функций они условный распределения , что означает, что для данного , они приписывают вероятности всем (и сумма этих вероятностей равна единице). Затем можно выполнить «жесткую» классификацию с помощью правило оптимального решения[2]:39–40

или, по-английски, предсказанный класс - это тот, который имеет наибольшую вероятность.

Бинарные вероятностные классификаторы также называют биномиальная регрессия модели в статистика. В эконометрика, вероятностная классификация в целом называется дискретный выбор.

Некоторые модели классификации, например наивный байесовский, логистическая регрессия и многослойные персептроны (при обучении под соответствующим функция потерь ) естественно вероятностны. Другие модели, такие как опорные векторные машины нет, но методы существуют превратить их в вероятностные классификаторы.

Генеративное и условное обучение

Некоторые модели, например логистическая регрессия, условно обучены: они оптимизируют условную вероятность непосредственно на обучающей выборке (см. минимизация эмпирического риска ). Другие классификаторы, например наивный байесовский, обучаются генеративно: во время обучения условное распределение классов и класс предшествующий найдены, а условное распределение выводится с использованием Правило Байеса.[2]:43

Калибровка вероятности

Не все классификационные модели являются естественно вероятностными, а некоторые из них, особенно наивные байесовские классификаторы, деревья решений и повышение методы, создают искаженные распределения вероятностей классов.[3] В случае деревьев решений, где Pr (у|Икс) это доля обучающих выборок с меткой у в листе, где Икс в конечном итоге эти искажения возникают из-за алгоритмов обучения, таких как C4.5 или КОРЗИНА явно стремиться производить однородные листья (с вероятностью, близкой к нулю или единице, и, следовательно, высокой предвзятость ) при использовании нескольких выборок для оценки соответствующей доли (высокая отклонение ).[4]

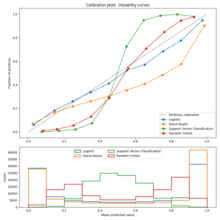

Калибровку можно оценить с помощью калибровочный график (также называемый диаграмма надежности).[3][5] График калибровки показывает долю элементов в каждом классе для диапазонов прогнозируемой вероятности или оценки (например, искаженное распределение вероятностей или «знаковое расстояние до гиперплоскости» в машине опорных векторов). Отклонения от функции идентичности указывают на плохо откалиброванный классификатор, для которого прогнозируемые вероятности или оценки не могут использоваться в качестве вероятностей. В этом случае можно использовать метод, чтобы превратить эти оценки в правильные откалиброванный вероятности членства в классе.

Для двоичный случае общий подход заключается в применении Масштабирование Платта, который изучает логистическая регрессия модель на счетах.[6]Альтернативный метод с использованием изотоническая регрессия[7] обычно превосходит метод Платта, когда доступно достаточно данных для обучения.[3]

в мультикласс В этом случае можно использовать редукцию к бинарным задачам с последующей одномерной калибровкой с помощью описанного выше алгоритма и дальнейшим применением алгоритма парного связывания Хасти и Тибширани.[8]

Оценка вероятностной классификации

Обычно используемые функции потерь для вероятностной классификации включают: потеря журнала и Оценка Бриера между предсказанным и истинным распределением вероятностей. Первый из них обычно используется для обучения логистических моделей.

Метод, используемый для присвоения баллов парам прогнозируемых вероятностей и фактических дискретных результатов, чтобы можно было сравнивать различные методы прогнозирования, называется правило подсчета очков.

использованная литература

- ^ Хасти, Тревор; Тибширани, Роберт; Фридман, Джером (2009). Элементы статистического обучения. п. 348. Архивировано с оригинал на 2015-01-26.

[В сбор данных приложений интерес часто больше в вероятностях классов сами, а не при выполнении задания в классе.

- ^ а б Епископ, Кристофер М. (2006). Распознавание образов и машинное обучение. Springer.

- ^ а б c Никулеску-Мизил, Александру; Каруана, Рич (2005). Предсказание хороших вероятностей с помощью контролируемого обучения (PDF). ICML. Дои:10.1145/1102351.1102430. Архивировано из оригинал (PDF) на 2014-03-11.

- ^ Задрозный, Бьянка; Элкан, Чарльз (2001). Получение калиброванных оценок вероятностей из деревьев решений и наивных байесовских классификаторов (PDF). ICML. С. 609–616.

- ^ «Калибровка вероятностей». jmetzen.github.io. Получено 2019-06-18.

- ^ Платт, Джон (1999). «Вероятностные выходы для опорных векторных машин и сравнения с регуляризованными методами правдоподобия». Достижения в классификаторах с большой маржой. 10 (3): 61–74.

- ^ Задрозный, Бьянка; Элкан, Чарльз (2002). «Преобразование оценок классификатора в точные оценки вероятности нескольких классов» (PDF). Материалы восьмой международной конференции ACM SIGKDD по обнаружению знаний и интеллектуальному анализу данных - KDD '02. С. 694–699. CiteSeerX 10.1.1.164.8140. Дои:10.1145/775047.775151. ISBN 978-1-58113-567-1. CiteSeerX: 10.1.1.13.7457.

- ^ Хасти, Тревор; Тибширани, Роберт (1998). «Классификация по попарному сцеплению». Анналы статистики. 26 (2): 451–471. CiteSeerX 10.1.1.309.4720. Дои:10.1214 / aos / 1028144844. Zbl 0932.62071. CiteSeerX: 10.1.1.46.6032.