Влияние искусственного интеллекта на рабочее место - Википедия - Workplace impact of artificial intelligence

Влияние искусственный интеллект на рабочих включает оба приложения для улучшения безопасность и здоровье работников, и потенциал опасности это нужно контролировать.

Одно из потенциальных приложений - использование ИИ для устранять опасности путем вывода людей из опасных ситуаций, связанных с риском стресс, переутомление, или же скелетно-мышечные травмы. Прогнозная аналитика может также использоваться для определения условий, которые могут привести к опасностям, таким как усталость, травмы от повторяющихся деформаций, или же воздействие токсичных веществ, что приводит к более раннему вмешательству. Другой - упростить безопасность и здоровье на рабочем месте рабочих процессов за счет автоматизации повторяющихся задач, улучшения программ обучения технике безопасности за счет виртуальная реальность, или обнаружение и сообщение близкие промахи.

При использовании на рабочем месте ИИ также представляет возможность новых опасностей. Они могут возникнуть из машинное обучение методы, ведущие к непредсказуемому поведению и непостижимость в их принятии решений или из информационная безопасность и конфиденциальность информации вопросы. Многие опасности ИИ психосоциальный из-за его способности вызывать изменения в организации труда. К ним относятся изменения навыков, требуемых от рабочих, усиление контроля, ведущее к микроменеджмент, алгоритмы непреднамеренно или намеренно подражание нежелательный человек предубеждения, и возложение вины для машинных ошибок оператору-человеку. ИИ может также привести к физические опасности в виде столкновения человека и робота, и эргономичный риски интерфейсов управления и человеко-машинного взаимодействия. Средства контроля опасностей включают меры кибербезопасности и конфиденциальности информации, обмен информацией и прозрачность с работниками в отношении использования данных, а также ограничения на коллаборативные роботы.

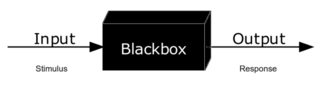

С точки зрения безопасности и здоровья на рабочем месте только «слабый» или «узкий» ИИ который адаптирован к конкретной задаче, актуален, так как есть много примеров, которые используются в настоящее время или, как ожидается, начнут применяться в ближайшем будущем. «Сильный» или «общий» ИИ не ожидается в ближайшем будущем, и обсуждение его риски находится в компетенции футуристов и философов, а не промышленные гигиенисты.

Приложения для здоровья и безопасности

Для того, чтобы любое потенциальное приложение ИИ по охране труда и технике безопасности было принято, оно требует одобрения как менеджеров, так и сотрудников. Например, принятие работниками может быть уменьшено опасениями по поводу конфиденциальность информации,[1] или из-за отсутствия доверия и принятия новой технологии, которые могут возникнуть из-за недостаточной прозрачности или недостаточного обучения.[2]:26–28, 43–45 В качестве альтернативы менеджеры могут подчеркивать увеличение экономическая производительность вместо повышения безопасности и здоровья работников при внедрении систем на базе ИИ.[3]

Устранение опасных задач

ИИ может увеличить объем рабочих задач, в которых может быть работник удалены из ситуации, которая несет в себе риск. В некотором смысле, в то время как традиционная автоматизация может заменить функции тела рабочего роботом, ИИ эффективно заменяет функции его мозга компьютером. Опасности, которые можно избежать включают стресс, переутомление, опорно-двигательного аппарата, травм и скуку.[4]:5–7

Это может расширить диапазон затронутых рабочих мест до белый воротничок и Сектор обслуживания рабочие места, такие как медицина, финансы и информационные технологии.[5] В качестве примера, колл-центр работники сталкиваются с серьезными рисками для здоровья и безопасности из-за его повторяющегося и требовательного характера и высокого уровня микронаблюдения. С поддержкой AI чат-боты снизить потребность людей в выполнении самых основных задач центра обработки вызовов.[4]:5–7

Аналитика для снижения риска

Машинное обучение используется для аналитика людей чтобы делать прогнозы о поведении сотрудников, чтобы помочь в принятии управленческих решений, таких как прием на работу и оценка производительности. Их также можно использовать для улучшения здоровья рабочих. Аналитика может основываться на вводимых данных, таких как онлайн-активность, мониторинг коммуникаций, отслеживание местоположения и голосовой анализ и анализ языка тела снятых интервью. Например, анализ настроений может использоваться для определения усталости, чтобы предотвратить переутомление.[4]:3–7 Системы поддержки принятия решений обладают аналогичной способностью, например, для предотвращения промышленные катастрофы или сделать реагирование на стихийные бедствия более эффективным.[8]

Для руководства обработка материалов рабочие, прогнозная аналитика и искусственный интеллект может использоваться для уменьшения скелетно-мышечная травма. Традиционные рекомендации основаны на средних статистических показателях и ориентированы на антропометрически типичные люди. Анализ больших объемов данных с носимых датчиков может позволить в режиме реального времени персонализированный расчет эргономичный риск и усталость управление, а также лучший анализ рисков, связанных с конкретными должностными ролями.[1]

Носимые датчики может также сделать возможным более раннее вмешательство в защиту от воздействия токсичных веществ, чем это возможно при периодической проверке площади или зоны дыхания. Кроме того, сгенерированные большие наборы данных могут улучшить наблюдение за здоровьем на рабочем месте, оценка рисков, и исследования.[8]

Оптимизация рабочих процессов, связанных с безопасностью и здоровьем

ИИ также можно использовать для создания безопасность и здоровье на рабочем месте рабочий процесс более эффективен. Одним из примеров является кодирование из компенсация рабочим претензии, которые представлены в форме прозаического повествования и которым вручную должны быть присвоены стандартизированные коды. ИИ исследуется, чтобы выполнять эту задачу быстрее, дешевле и с меньшим количеством ошибок.[9][10]

С поддержкой AI виртуальная реальность системы могут быть полезны для обучения технике безопасности при распознавании опасностей.[8]

Искусственный интеллект можно использовать для более эффективного обнаружения близкие промахи. Отчетность и анализ предаварийных ситуаций важны для снижения количества несчастных случаев, но о них часто не сообщают, потому что они не замечаются людьми или не сообщаются рабочими из-за социальных факторов.[11]

Опасности

Есть несколько аспектов ИИ, которые могут привести к более специфическим опасностям. Риски зависят от реализации, а не от простого присутствия ИИ.[4]:2–3

Системы, использующие субсимвольный ИИ, такие как машинное обучение могут вести себя непредсказуемо и более склонны к непостижимость в принятии решений. Это особенно верно, если возникает ситуация, которая не была частью ИИ. набор обучающих данных, и усугубляется в менее структурированной среде. Нежелательное поведение может также возникать из-за недостатков в системе. восприятие (возникающие либо из программного обеспечения, либо из датчик деградация), представление знаний и рассуждения, или из программные ошибки.[2]:14–18 Они могут возникнуть в результате неправильного обучения, например, когда пользователь применяет один и тот же алгоритм к двум задачам, к которым не предъявляются разные требования.[4]:12–13 Машинное обучение, применяемое на этапе проектирования, может иметь иные последствия, чем применяемое в время выполнения. Системы, использующие символический ИИ менее склонны к непредсказуемому поведению.[2]:14–18

Также увеличивается использование ИИ информационная безопасность риски, связанные с платформами, не использующими ИИ,[2]:17 и конфиденциальность информации опасения по поводу собранных данных могут представлять опасность для работников.[1]

Психосоциальный

Психосоциальные опасности это те, которые возникают в результате того, как работа спроектирована, организована и управляется, или из ее экономических и социальных контекстов, а не из физической субстанции или объекта. Они вызывают не только психиатрический и психологические последствия, такие как профессиональное выгорание, тревожные расстройства, и депрессия, но они также могут вызвать физические травмы или заболевания, например сердечно-сосудистые заболевания или же скелетно-мышечная травма.[12] Многие опасности ИИ носят психосоциальный характер из-за его способности вызывать изменения в организации труда с точки зрения увеличения сложности и взаимодействия между различными организационными факторами. Однако разработчики передовых производственных систем часто не обращают внимания на психосоциальные риски.[3]

Изменения в практике работы

Ожидается, что ИИ приведет к изменениям в навыках, требуемых от рабочих, что потребует обучение персонала существующих сотрудников, гибкости и открытости к изменениям. Требование сочетания традиционных знаний с компьютерными навыками может быть сложной задачей для существующих сотрудников.[3] Чрезмерное использование инструментов ИИ может привести к дескиллинг некоторых профессий.[8]

Усиленный мониторинг может привести к микроменеджмент и, следовательно, к стрессу и тревоге. Восприятие наблюдение также может привести к стрессу. К ним относятся консультации с рабочими группами, обширное тестирование и внимание к внесенной предвзятости. Носимые датчики, трекеры активности, и дополненная реальность также может вызвать стресс из-за микроменеджмента, как для рабочих конвейера, так и для рабочие. Гигантским работникам также не хватает правовой защиты и прав официальных работников.[4]:2–10

Также существует риск того, что людей заставят работать в темпе робота или контролировать его работу в нестандартные часы.[4]:5–7

Предвзятость

Алгоритмы, обученные прошлым решениям, могут имитировать нежелательные человеческие предубеждения, например, прошлое дискриминационная практика найма и увольнения. Информационная асимметрия между руководством и работниками может привести к стрессу, если работники не имеют доступа к данным или алгоритмам, которые являются основой для принятия решений.[4]:3–5

Помимо построения модели с непреднамеренно дискриминационными характеристиками, преднамеренная дискриминация может происходить путем разработки показателей, которые тайно приводят к дискриминации через коррелированные переменные неочевидным образом.[4]:12–13

В сложных взаимодействиях человека с машиной некоторые подходы к анализ аварии может быть склонен защищать технологическую систему и ее разработчиков возложение вины вместо этого отдельному человеку-оператору.[8]

Физический

Физические опасности в виде столкновений человека с роботом могут возникнуть в результате использования ИИ роботами, особенно совместными роботами (коботы ). Коботы предназначены для работы в непосредственной близости от людей, что делает невозможным общий контроль опасности изоляция робота использование заборов или других барьеров, что широко используется для традиционных промышленные роботы. Автоматизированные управляемые машины - это тип коботов, которые с 2019 года широко используются, часто как погрузчики или же домкраты для поддонов в склады или же фабрики.[2]:5, 29–30 Беспилотные автомобили - еще один пример роботов с ИИ.[3]

За коботы, неисправности датчиков или непредвиденные условия рабочей среды могут привести к непредсказуемому поведению робота и, как следствие, к столкновениям человека и робота.[4]:5–7 В дополнение эргономика интерфейсов управления и взаимодействия человека с машиной могут привести к возникновению опасностей.[3]

Контроль опасностей

ИИ, как и другие вычислительные технологии, требует информационная безопасность меры по предотвращению взлома программного обеспечения и вторжений[2]:17 и конфиденциальность информации меры.[1] Общение и прозрачность с работниками в отношении использования данных - это средство контроля психосоциальных опасностей, связанных с проблемами безопасности и конфиденциальности.[1] Предлагаемые передовые методы для программ мониторинга работников, спонсируемых работодателем, включают использование только проверенных сенсорных технологий; обеспечение участия добровольцев; прекращение сбора данных вне рабочего места; раскрытие всех видов использования данных; и обеспечение безопасного хранения данных.[8]

Для промышленных коботов, оснащенных датчиками с поддержкой AI, Международная организация по стандартизации (ISO) рекомендовал: (a) контролируемые средства управления остановкой, связанные с безопасностью; (б) человеческая рука, управляющая коботом; (c) средства контроля скорости и эшелонирования; и (d) ограничения мощности и силы. Сетевые коботы с поддержкой ИИ могут делиться друг с другом улучшениями безопасности.[8] Человеческий надзор - еще один общий контроль над опасностями для ИИ.[4]:12–13

Управление рисками

И приложения, и опасности, связанные с ИИ, можно рассматривать как часть существующих структур для управление рисками для здоровья и безопасности труда. Как и в случае со всеми опасностями, идентификация рисков наиболее эффективна и наименее затратна, когда сделано на этапе проектирования.[3]

Наблюдение за здоровьем на рабочем месте, сбор и анализ данных о состоянии здоровья работников, является сложной задачей для ИИ, поскольку данные о труде часто представляются в совокупности и не содержат разбивки по различным типам работы, а сосредоточены на экономических данных, таких как заработная плата и уровень занятости, а не на содержании навыков. рабочих мест. Заместители содержания навыков включают образовательные требования и классификацию рутинных и нестандартных работ, а также когнитивных и физических работ. Однако они все еще могут быть недостаточно конкретными, чтобы отличить определенные профессии, которые имеют отличное влияние от ИИ. В Министерство труда США с Сеть профессиональной информации это пример базы данных с подробной классификацией навыков. Кроме того, данные часто сообщаются на национальном уровне, хотя географические различия сильно различаются, особенно между городскими и сельскими районами.[5]

Стандарты и правила

По состоянию на 2019 год[Обновить], ISO разрабатывала стандарт об использовании показателей и приборные панели, информационные дисплеи, представляющие метрики компании для менеджеров на рабочих местах. Планируется, что в стандарт будут включены рекомендации как по сбору данных, так и по отображению их в удобной и удобной для просмотра форме.[4]:11[13][14]

в Евросоюз, то Общие правила защиты данных, хотя и ориентирован на данные о потребителях, также актуален для сбора данных о рабочих местах. Субъекты данных, в том числе работники, имеют «право не подчиняться решению, основанному исключительно на автоматизированной обработке». Другие соответствующие Директивы ЕС включить Директива по машинному оборудованию (2006/42 / EC), Директива по радиооборудованию (2014/53 / EU) и Общая директива по безопасности продукции (2001/95 / EC).[4]:10, 12–13

Рекомендации

- ^ а б c d е Джанатти, Тони-Луиза (14 мая 2020 г.). «Как алгоритмы на основе ИИ повышают эргономическую безопасность человека». Охрана труда и безопасность. Получено 2020-07-30.

- ^ а б c d е ж Янсен, Энн; ван дер Бик, Дольф; Кремерс, Анита; Neerincx, Марк; ван Мидделаар, Йохан (28.08.2018). «Возникающие риски для безопасности рабочего места: работа в одном помещении с коботом». Нидерландская организация прикладных научных исследований (TNO). Получено 2020-08-12.

- ^ а б c d е ж Бадри, Адель; Будро-Трудель, Брайан; Суиси, Ахмед Саадеддин (01.11.2018). «Охрана труда и безопасность в эпоху Индустрии 4.0: причина для серьезного беспокойства?». Наука о безопасности. 109: 403–411. Дои:10.1016 / j.ssci.2018.06.012.

- ^ а б c d е ж грамм час я j k л м Мур, Фиби В. (07.05.2019). «Охрана труда и будущее труда: преимущества и риски инструментов искусственного интеллекта на рабочих местах». EU-OSHA. Получено 2020-07-30.

- ^ а б Франк, Морган Р .; Автор, Дэвид; Бессен, Джеймс Э .; Бриньолфссон, Эрик; Кебриан, Мануэль; Деминг, Дэвид Дж .; Фельдман, Марианн; Гро, Мэтью; Лобо, Хосе; Моро, Эстебан; Ван, Дашунь (2019-04-02). «К пониманию влияния искусственного интеллекта на труд». Труды Национальной академии наук. 116 (14): 6531–6539. Дои:10.1073 / pnas.1900949116. ISSN 0027-8424. ЧВК 6452673. PMID 30910965.

- ^ Уорнер, Эмили; Худок, Стивен Д .; Лу, Джек (2017-08-25). «NLE Calc: мобильное приложение, основанное на пересмотренном уравнении подъема NIOSH». Научный блог NIOSH. Получено 2020-08-17.

- ^ «Руководство по применению пересмотренного уравнения подъема NIOSH». Национальный институт охраны труда и здоровья США. 1994-01-01. Дои:10.26616 / NIOSHPUB94110.

- ^ а б c d е ж грамм Ховард, Джон (2019-11-01). «Искусственный интеллект: последствия для будущего работы». Американский журнал промышленной медицины. 62 (11): 917–926. Дои:10.1002 / ajim.23037. ISSN 0271-3586. PMID 31436850.

- ^ Мейерс, Алиша Р. (01.05.2019). «AI и рабочий комп». Научный блог NIOSH. Получено 2020-08-03.

- ^ Уэбб, Сидней; Сиордия, Карлос; Бертке, Стивен; Бартлетт, Диана; Рейц, Дэн (26 февраля 2020 г.). «Конкурс краудсорсинга искусственного интеллекта для наблюдения за травмами». Научный блог NIOSH. Получено 2020-08-03.

- ^ Фергюсон, Мюррей (19 апреля 2016 г.). «Искусственный интеллект: что будет с EHS… и когда?». EHS сегодня. Получено 2020-07-30.

- ^ Брун, Эммануэль; Милчарек, Малгожата (2007). «Экспертный прогноз возникающих психосоциальных рисков, связанных с охраной труда». Европейское агентство по безопасности и гигиене труда. Получено 3 сентября, 2015.

- ^ Мур, Фиби В. (2014-04-01). «Вопросы безопасности и гигиены труда в эпоху искусственного интеллекта». Kommission Arbeitsschutz und Normung. Получено 2020-08-06.

- ^ «Стандарты ISO / IEC JTC 1 / SC 42 - Искусственный интеллект». Международная организация по стандартизации. Получено 2020-08-06.