Обычный метод наименьших квадратов - Ordinary least squares

| Часть серии по |

| Регрессивный анализ |

|---|

|

| Модели |

| Предварительный расчет |

| Задний план |

|

В статистика, обыкновенный метод наименьших квадратов (OLS) является разновидностью линейный метод наименьших квадратов метод оценки неизвестного параметры в линейная регрессия модель. OLS выбирает параметры линейная функция набора объясняющие переменные по принципу наименьших квадратов: минимизация суммы квадратов различий между наблюдаемыми зависимая переменная (значения наблюдаемой переменной) в данной набор данных и те, которые предсказываются линейной функцией.

Геометрически это рассматривается как сумма квадратов расстояний, параллельных оси зависимой переменной, между каждой точкой данных в наборе и соответствующей точкой на поверхности регрессии - чем меньше различия, тем лучше модель соответствует данным. . Результирующий оценщик можно выразить простой формулой, особенно в случае простая линейная регрессия, в котором есть одиночный регрессор в правой части уравнения регрессии.

МНК-оценка последовательный когда регрессоры экзогенный, и - Теорема Гаусса – Маркова —оптимальный в классе линейных несмещенных оценок когда ошибки находятся гомоскедастический и серийно некоррелированный. В этих условиях метод OLS обеспечивает минимальное отклонение среднее несмещенное оценка при конечных ошибках отклонения. При дополнительном предположении, что ошибки нормально распределенный, OLS - это оценщик максимального правдоподобия.

Линейная модель

Предположим, что данные состоят из п наблюдения { yя, Икся }п

я = 1. Каждое наблюдение я включает скалярный ответ yя и вектор-столбец Икся ценностей п параметры (регрессоры) Иксij для j = 1, ..., п. В модель линейной регрессии, переменная ответа, , является линейной функцией регрессоров:

или в вектор форма

где Икся вектор-столбец яые наблюдения всех объясняющих переменных; это п× 1 вектор неизвестных параметров; и скаляры εя представляют ненаблюдаемые случайные величины (ошибки ), которые учитывают влияние на ответы yя из других источников, кроме пояснительных Икся. Эта модель также может быть записана в матричных обозначениях как

где y и ε находятся п× 1 векторы значений переменной отклика и ошибок для различных наблюдений, и Икс является п×п матрица регрессоров, также иногда называемая матрица дизайна, чья строка я является ИксяТ и содержит яые наблюдения по всем независимым переменным.

Как правило, постоянный член всегда входит в набор регрессоров. Икс, скажем, взяв Икся1 = 1 для всех я = 1, ..., п. Коэффициент β1 соответствующий этому регрессору называется перехватить.

Регрессоры не обязательно должны быть независимыми: между регрессорами может быть любое желаемое отношение (при условии, что оно не является линейным). Например, мы можем подозревать, что ответ линейно зависит как от значения, так и от его квадрата; в этом случае мы должны включить один регрессор, значение которого равно квадрату другого регрессора. В этом случае модель будет квадратичный во втором регрессоре, но тем не менее считается линейный модель, потому что модель является по-прежнему линейна по параметрам (β).

Матричная / векторная формулировка

Рассмотрим сверхдетерминированная система

из п линейные уравнения в п неизвестно коэффициенты, β1, β2, ..., βп, с участием п > п. (Примечание: для линейной модели, как указано выше, не все Икс содержит информацию о точках данных. Первый столбец заполнен единицами, , только другие столбцы содержат фактические данные, поэтому здесь п = количество регрессоров + 1.) Это можно записать в матрица форма как

где

Такая система обычно не имеет точного решения, поэтому цель состоит в том, чтобы найти коэффициенты которые соответствуют уравнениям "наилучшим образом" в смысле решения квадратичный минимизация проблема

где целевая функция S дан кем-то

Обоснование выбора этого критерия приведено в Свойства ниже. Эта задача минимизации имеет уникальное решение при условии, что п столбцы матрицы Икс находятся линейно независимый, заданный путем решения нормальные уравнения

Матрица известен как нормальная матрица и матрица известен как матрица моментов регресса и регрессорами.[1] В заключение, вектор коэффициентов наименьших квадратов гиперплоскость, выраженный как

Предварительный расчет

Предположим б значение "кандидата" для вектора параметров β. Количество yя − ИксяТб, называется остаточный для я-е наблюдение, измеряет расстояние по вертикали между точками данных (Икся, yя) и гиперплоскость y = ИксТб, и таким образом оценивает степень соответствия между фактическими данными и моделью. В сумма квадратов остатков (ССР) (также называемый сумма квадратов ошибок (ESS) или остаточная сумма квадратов (RSS))[2] является мерой соответствия модели в целом:

где Т обозначает матрицу транспонировать, а ряды Икс, обозначающие значения всех независимых переменных, связанных с определенным значением зависимой переменной, являются Икся = хяТ. Значение б который минимизирует эту сумму, называется Оценщик OLS для β. Функция S(б) квадратично по б с положительно определенным Гессен, поэтому эта функция обладает единственным глобальным минимумом на , который может быть задан явной формулой:[3][доказательство]

Продукт N=ИксТ Икс это нормальная матрица и его обратное, Q=N–1, это матрица кофакторов из β,[4][5][6] тесно связан с его ковариационная матрица, Cβ.Матрица (ИксТ Икс)–1 ИксТ=Q ИксТ называется Псевдообратная матрица Мура – Пенроуза матрица X. Эта формулировка подчеркивает, что оценка может быть выполнена тогда и только тогда, когда не существует идеального мультиколлинеарность между независимыми переменными (что приведет к тому, что нормальная матрица не будет иметь обратной).

После того, как мы оценили β, то подогнанные значения (или прогнозируемые значения) от регрессии будет

где п = Икс(ИксТИкс)−1ИксТ это матрица проекции в космос V покрытый столбцами Икс. Эта матрица п также иногда называют шляпа матрица потому что это "ставит шляпу" на переменную y. Другая матрица, тесно связанная с п это аннигилятор матрица M = яп − п; это матрица проекции на пространство, ортогональное V. Обе матрицы п и M находятся симметричный и идемпотент (означающий, что п2 = п и M2 = M), и относятся к матрице данных Икс через личности PX = Икс и MX = 0.[7] Матрица M создает остатки из регрессии:

Используя эти невязки, мы можем оценить значение σ 2 с использованием уменьшенный хи-квадрат статистика:

Знаменатель, п−п, это статистические степени свободы. Первое количество, s2, - оценка МНК для σ2, а второй , - оценка MLE для σ2. Эти две оценки очень похожи в больших выборках; первая оценка всегда беспристрастный, а вторая оценка смещена, но имеет меньшую среднеквадратичная ошибка. На практике s2 используется чаще, так как это удобнее для проверки гипотез. Квадратный корень из s2 называется стандартная ошибка регрессии,[8] стандартная ошибка регрессии,[9][10] или стандартная ошибка уравнения.[7]

Обычно степень согласия регрессии МНК обычно оценивают путем сравнения того, насколько первоначальная вариация в выборке может быть уменьшена путем регрессии на Икс. В коэффициент детерминации р2 определяется как отношение «объясненной» дисперсии к «общей» дисперсии зависимой переменной. y, в тех случаях, когда сумма квадратов регрессии равна сумме квадратов остатков:[11]

где TSS - общая сумма квадратов для зависимой переменной, L = яп − 11Т/ п, и 1 является п× 1 вектор единиц. (L является «центрирующей матрицей», которая эквивалентна регрессии по константе; он просто вычитает среднее значение из переменной.) р2 чтобы иметь смысл, матрица Икс данных о регрессорах должен содержать вектор-столбец из единиц для представления константы, коэффициент которой является точкой пересечения регрессии. В этом случае, р2 всегда будет числом от 0 до 1, а значения, близкие к 1, указывают на хорошую степень соответствия.

Дисперсия прогноза независимой переменной как функции зависимой переменной приведена в статье. Полиномиальные наименьшие квадраты.

Модель простой линейной регрессии

Если матрица данных Икс содержит только две переменные, константу и скалярный регрессор Икся, то это называется «простой регрессионной моделью».[12] Этот случай часто рассматривается в классах статистики для начинающих, поскольку он предоставляет гораздо более простые формулы, подходящие даже для ручного расчета. Параметры обычно обозначаются как (α, β):

Оценки наименьших квадратов в этом случае даются простыми формулами

где Var (.) и Cov (.) - параметры выборки.

Альтернативные производные

В предыдущем разделе оценщик наименьших квадратов был получен как значение, которое минимизирует сумму квадратов остатков модели. Однако можно получить такую же оценку и из других подходов. Во всех случаях формула для оценки МНК остается прежней: ^β = (ИксТИкс)−1ИксТy; единственная разница в том, как мы интерпретируем этот результат.

Проекция

Возможно, этот раздел необходимо очистить. Он был объединен с Линейный метод наименьших квадратов (математика). |

Для математиков OLS - это приближенное решение переопределенной системы линейных уравнений. Xβ ≈ y, где β это неизвестное. Если предположить, что система не может быть решена точно (количество уравнений п намного больше, чем количество неизвестных п), мы ищем решение, которое могло бы обеспечить наименьшее расхождение между правой и левой частями. Другими словами, мы ищем решение, удовлетворяющее

где || · || это стандарт L2 норма в п-размерный Евклидово пространство рп. Прогнозируемое количество Xβ есть некая линейная комбинация векторов регрессоров. Таким образом, остаточный вектор y − Xβ будет иметь наименьшую длину, когда y является проецируется ортогонально на линейное подпространство охватывал колоннами Икс. Оценщик OLS в этом случае можно интерпретировать как коэффициенты векторное разложение из ^y = Py на основе Икс.

Другими словами, уравнения градиента по минимуму можно записать как:

Геометрическая интерпретация этих уравнений состоит в том, что вектор невязок, ортогонален пространство столбца из Икс, поскольку скалярное произведение равен нулю для Любые конформный вектор, v. Это значит, что самый короткий из всех возможных векторов , то есть дисперсия остатков минимально возможна. Это показано справа.

Представляем и матрица K в предположении, что матрица неособен и KТ Икс = 0 (ср. Ортогональные проекции ), остаточный вектор должен удовлетворять следующему уравнению:

Таким образом, уравнение и решение линейных наименьших квадратов описываются следующим образом:

Другой способ взглянуть на это - рассматривать линию регрессии как средневзвешенное значение линий, проходящих через комбинацию любых двух точек в наборе данных.[13] Хотя этот способ расчета более затратен с точки зрения вычислений, он обеспечивает лучшую интуицию на OLS.

Максимальная вероятность

Оценщик OLS идентичен оценке оценщик максимального правдоподобия (MLE) в предположении нормальности для ошибок.[14][доказательство] Это предположение о нормальности имеет историческое значение, поскольку оно послужило основой для ранних работ в области линейного регрессионного анализа. Йоль и Пирсон.[нужна цитата ] Из свойств MLE мы можем сделать вывод, что оценка OLS асимптотически эффективна (в смысле достижения Граница Крамера – Рао для дисперсии), если выполняется предположение о нормальности.[15]

Обобщенный метод моментов

В iid случае МНК-оценку также можно рассматривать как GMM оценка, возникающая из моментных условий

Эти моментные условия утверждают, что регрессоры не должны коррелировать с ошибками. поскольку Икся это п-вектор, количество моментных состояний равно размерности вектора параметров β, и таким образом система точно идентифицирована. Это так называемый классический случай GMM, когда оценка не зависит от выбора весовой матрицы.

Обратите внимание, что исходное строгое предположение экзогенности E [εя | Икся] = 0 подразумевает гораздо более богатый набор моментных условий, чем указано выше. В частности, из этого предположения следует, что для любой вектор-функции ƒ, моментное условие E [ƒ(Икся)·εя] = 0 будет держать. Однако это можно показать с помощью Теорема Гаусса – Маркова что оптимальный выбор функции ƒ должен взять ƒ(Икс) = Икс, что приводит к приведенному выше уравнению момента.

Свойства

Предположения

Есть несколько различных структур, в которых модель линейной регрессии может быть отлит, чтобы применить технику OLS. Каждый из этих параметров дает одинаковые формулы и одинаковые результаты. Единственная разница заключается в интерпретации и допущениях, которые должны быть наложены, чтобы метод дал значимые результаты. Выбор применяемой структуры зависит главным образом от природы имеющихся данных и от задачи вывода, которую необходимо выполнить.

Одна из линий разницы в интерпретации заключается в том, следует ли рассматривать регрессоры как случайные величины или как предопределенные константы. В первом случае (случайный дизайн) регрессоры Икся являются случайными и отбираются вместе с yяиз некоторых Население, как в наблюдательное исследование. Такой подход позволяет более естественным образом изучить асимптотические свойства оценщиков. В другой интерпретации (фиксированный дизайн), регрессоры Икс рассматриваются как известные константы, установленные дизайн, и y отбирается условно по значениям Икс как в эксперимент. Для практических целей это различие часто не имеет значения, поскольку оценка и логический вывод выполняются, пока Икс. Все результаты, изложенные в этой статье, находятся в рамках случайного проектирования.

Классическая модель линейной регрессии

Классическая модель фокусируется на оценке и выводе "конечной выборки", что означает, что количество наблюдений п фиксированный. Это контрастирует с другими подходами, изучающими асимптотическое поведение OLS, и в котором количество наблюдений может расти до бесконечности.

- Правильная спецификация. Линейная функциональная форма должна совпадать с формой фактического процесса генерации данных.

- Строгая экзогенность. Ошибки в регрессии должны иметь условное среднее нуль:[16]

- Непосредственным следствием предположения об экзогенности является то, что ошибки имеют нулевое среднее значение: E [ε] = 0, и что регрессоры не коррелируют с ошибками: E [ИксТε] = 0.

- Предположение экзогенности имеет решающее значение для теории OLS. Если это так, переменные регрессора называются экзогенный. Если это не так, то те регрессоры, которые коррелируют с ошибкой, называются эндогенный,[17] и тогда оценки OLS становятся недействительными. В таком случае метод инструментальных переменных может использоваться для вывода.

- Нет линейной зависимости. Регрессоры в Икс все должно быть линейно независимый. Математически это означает, что матрица Икс должен иметь полный ранг столбца почти наверняка:[18]

- Обычно также предполагается, что регрессоры имеют конечные моменты, по крайней мере, до второго момента. Тогда матрица Qхх = E [ИксТИкс / п] конечно и положительно полуопределенно.

- Когда это предположение нарушается, регрессоры называют линейно зависимыми или идеально мультиколлинеарен. В таком случае значение коэффициента регрессии β невозможно узнать, хотя предсказание y values все еще возможен для новых значений регрессоров, которые лежат в том же линейно зависимом подпространстве.

- Сферические ошибки:[18]

- где яп это единичная матрица в измерении п, и σ2 - параметр, определяющий дисперсию каждого наблюдения. Эта σ2 считается неприятный параметр в модели, хотя обычно и оценивается. Если это предположение нарушается, то оценки OLS по-прежнему действительны, но уже неэффективны.

- Это предположение принято разделять на две части:

- Гомоскедастичность: E [εя2 | Икс ] = σ2, что означает, что член ошибки имеет такую же дисперсию σ2 в каждом наблюдении. Когда это требование нарушается, это называется гетероскедастичность, в таком случае более эффективная оценка была бы взвешенный метод наименьших квадратов. Если ошибки имеют бесконечную дисперсию, то оценки OLS также будут иметь бесконечную дисперсию (хотя закон больших чисел они, тем не менее, будут стремиться к истинным значениям, пока ошибки имеют нулевое среднее). В таком случае, робастная оценка рекомендуются техники.

- Нет автокорреляция: ошибки некоррелированный между наблюдениями: E [εяεj | Икс ] = 0 для я ≠ j. Это предположение может быть нарушено в контексте Временные ряды данные, данные панели, кластерные выборки, иерархические данные, данные повторных измерений, продольные данные и другие данные с зависимостями. В таких случаях обобщенный метод наименьших квадратов обеспечивает лучшую альтернативу, чем OLS. Еще одно выражение для автокорреляции: серийная корреляция.

- Нормальность. Иногда дополнительно предполагают, что ошибки имеют нормальное распределение условно от регрессоров:[19]

- Это предположение не требуется для достоверности метода OLS, хотя некоторые дополнительные свойства конечной выборки могут быть установлены в том случае, если это произойдет (особенно в области проверки гипотез). Также, когда ошибки нормальные, оценка МНК эквивалентна оценке оценщик максимального правдоподобия (MLE), поэтому он асимптотически эффективен в классе всех регулярные оценщики. Важно отметить, что предположение о нормальности применимо только к ошибочным членам; вопреки распространенному заблуждению, переменная ответа (зависимая) не обязательно должна иметь нормальное распределение.[20]

Независимые и одинаково распределенные (iid)

В некоторых приложениях, особенно с данные поперечного сечения, накладывается дополнительное предположение - что все наблюдения независимы и одинаково распределены. Это означает, что все наблюдения взяты из случайный пример что упрощает все перечисленные ранее допущения и облегчает их интерпретацию. Также эта структура позволяет сформулировать асимптотические результаты (поскольку размер выборки п → ∞), которые понимаются как теоретическая возможность получения новых независимых наблюдений из процесс генерации данных. Список предположений в этом случае:

- iid наблюдения: (Икся, yя) является независимый из, и имеет то же самое распространение так как, (Иксj, yj) для всех я ≠ j;

- нет идеальной мультиколлинеарности: Qхх = E [Икся ИксяТ ] это положительно определенная матрица;

- экзогенность: E [εя | Икся ] = 0;

- гомоскедастичность: Вар [εя | Икся ] = σ2.

Модель временного ряда

- В случайный процесс {Икся, yя} является стационарный и эргодический; если {Икся, yя} нестационарен, результаты OLS часто бывают ложными, если {Икся, yя} является совместная интеграция.

- Регрессоры предопределенный: E [Иксяεя] = 0 для всех я = 1, ..., п;

- В п×п матрица Qхх = E [Икся ИксяТ ] имеет полный ранг, а значит положительно определенный;

- {Иксяεя} это последовательность разностей мартингалов, с конечной матрицей вторых моментов Qxxε² = E [εя2Икся ИксяТ ].

Свойства конечного образца

Прежде всего, под строгая экзогенность предположить, что оценки МНК и s2 находятся беспристрастный, что означает, что их ожидаемые значения совпадают с истинными значениями параметров:[21][доказательство]

Если строгая экзогенность не выполняется (как в случае со многими Временные ряды модели, где экзогенность предполагается только в отношении прошлых шоков, но не будущих), то эти оценки будут смещены в конечных выборках.

В ковариационная матрица (или просто ковариационная матрица) из равно[22]

В частности, стандартная ошибка каждого коэффициента равен квадратному корню из j-й диагональный элемент этой матрицы. Оценка этой стандартной ошибки получается заменой неизвестной величины σ2 со своей оценкой s2. Таким образом,

Также легко показать, что оценка не коррелирует с остатками из модели:[22]

В Теорема Гаусса – Маркова заявляет, что под сферические ошибки предположение (то есть ошибки должны быть некоррелированный и гомоскедастический ) оценщик эффективен в классе линейных несмещенных оценок. Это называется лучшая линейная несмещенная оценка (СИНИЙ). Эффективность следует понимать так, как если бы мы хотели найти какую-то другую оценку. который был бы линейным по y и беспристрастно, то [22]

в том смысле, что это неотрицательно-определенная матрица. Эта теорема устанавливает оптимальность только в классе линейных несмещенных оценок, что весьма ограничительно. В зависимости от распределения ошибок ε, другие, нелинейные оценки могут дать лучшие результаты, чем OLS.

Предполагая нормальность

Все перечисленные до сих пор свойства действительны независимо от основного распределения условий ошибки. Однако если вы готовы предположить, что предположение о нормальности выполняется (то есть ε ~ N(0, σ2яп)), то можно указать дополнительные свойства МНК-оценок.

Оценщик имеет нормальное распределение со средним значением и дисперсией, как указано выше:[23]

где Q это матрица кофакторов. Эта оценка достигает Граница Крамера – Рао для модели и, таким образом, оптимален в классе всех несмещенных оценок.[15] Обратите внимание, что в отличие от Теорема Гаусса – Маркова, этот результат устанавливает оптимальность как линейных, так и нелинейных оценок, но только в случае нормально распределенных членов ошибки.

Оценщик s2 будет пропорционально распределение хи-квадрат:[24]

Дисперсия этой оценки равна 2σ4/(п − п), который не достигает Граница Крамера – Рао из 2σ4/п. Однако было показано, что объективных оценок σ2 с дисперсией меньше, чем у оценки s2.[25] Если мы готовы допустить предвзятые оценки и рассмотреть класс оценок, которые пропорциональны сумме квадратов остатков (SSR) модели, то лучший (в смысле среднеквадратичная ошибка ) оценщик в этом классе будет ~σ2 = SSR/ (п − п + 2), что даже превосходит границу Крамера – Рао в случае, когда имеется только один регрессор (п = 1).[26]

Более того, оценщики и s2 находятся независимый,[27] факт, который пригодится при построении t- и F-тестов для регрессии.

Влиятельные наблюдения

Как упоминалось ранее, оценщик линейно по y, что означает, что он представляет собой линейную комбинацию зависимых переменных yя. Веса в этой линейной комбинации являются функциями регрессоров Икс, и, как правило, неравны. Наблюдения с большим весом называются влиятельный потому что они имеют более выраженное влияние на значение оценщика.

Чтобы проанализировать, какие наблюдения имеют большое значение, мы удаляем конкретный j-е наблюдение и подумайте, насколько изменятся расчетные количества (аналогично складной нож ). Можно показать, что изменение оценки МНК для β будет равно [28]

где часj = ИксjТ (ИксТИкс)−1Иксj это j-й диагональный элемент матрицы шляпы п, и Иксj - вектор регрессоров, соответствующий j-е наблюдение. Аналогичным образом изменение прогнозируемого значения для j-е наблюдение в результате исключения этого наблюдения из набора данных будет равно [28]

Из свойств матрицы шляпы, 0 ≤ часj ≤ 1, и они суммируют п, так что в среднем часj ≈ п / п. Эти количества часj называются рычаги, и наблюдения с высоким часj называются точки кредитного плеча.[29] Обычно наблюдения с большим кредитным плечом должны быть изучены более тщательно, если они ошибочны, выпадают или каким-либо иным образом нетипичны для остальной части набора данных.

Разделенная регрессия

Иногда переменные и соответствующие параметры в регрессии можно логически разделить на две группы, так что регрессия принимает вид

где Икс1 и Икс2 иметь размеры п×п1, п×п2, и β1, β2 находятся п1× 1 и п2× 1 векторов, с п1 + п2 = п.

В Теорема Фриша – Во – Ловелла. утверждает, что в этой регрессии остатки и оценка МНК будут численно идентичны остаткам и оценке МНК для β2 в следующей регрессии:[30]

где M1 это аннигиляторная матрица для регрессоров Икс1.

Теорема может быть использована для получения ряда теоретических результатов. Например, наличие регрессии с константой и другим регрессором эквивалентно вычитанию средних значений из зависимой переменной и регрессора и последующему запуску регрессии для переменных без значения, но без постоянного члена.

Ограниченная оценка

Предположим, известно, что коэффициенты регрессии удовлетворяют системе линейных уравнений

где Q это п×q матрица полного ранга, и c это q× 1 вектор известных констант, где д <р. В этом случае оценка методом наименьших квадратов эквивалентна минимизации суммы квадратов остатков модели с учетом ограничения А. В метод наименьших квадратов с ограничениями (CLS) оценка может быть дана явной формулой:[31]

Это выражение для оценки с ограничениями действительно до тех пор, пока матрица ИксТИкс обратимо. С самого начала этой статьи предполагалось, что эта матрица имеет полный ранг, и было отмечено, что, когда условие ранга не выполняется, β не будет идентифицирован. Однако может случиться так, что добавление ограничения А делает β идентифицируемый, и в этом случае нужно найти формулу для оценки. Оценщик равен [32]

где р это п×(п − q) матрица такая, что матрица [Q R] неособен, и рТQ = 0. Такую матрицу всегда можно найти, хотя в целом она не уникальна. Вторая формула совпадает с первой в случае, когда ИксТИкс обратимо.[32]

Свойства большого образца

Оценщики наименьших квадратов: точечные оценки параметров модели линейной регрессии β. Однако обычно мы также хотим знать, насколько близки эти оценки к истинным значениям параметров. Другими словами, мы хотим построить интервальные оценки.

Поскольку мы не делали никаких предположений о распределении ошибки εя, невозможно вывести распределение оценок и . Тем не менее, мы можем применить Центральная предельная теорема вывести их асимптотический свойства как размер выборки п уходит в бесконечность. Хотя размер выборки обязательно конечен, принято считать, что п является «достаточно большим», так что истинное распределение оценки OLS близко к его асимптотическому пределу.

Можно показать, что в предположениях модели оценка методом наименьших квадратов для β является последовательный (это сходится по вероятности к β) и асимптотически нормально:[доказательство]

где

Интервалы

Используя это асимптотическое распределение, приблизьте двусторонние доверительные интервалы для j-я компонента вектора можно построить как

- на 1 − α уровень уверенности,

где q обозначает квантильная функция стандартного нормального распределения и [·]jj это j-й диагональный элемент матрицы.

Аналогично, оценка методом наименьших квадратов для σ2 также непротиворечиво и асимптотически нормально (при условии, что четвертый момент εя существует) с предельным распределением

Эти асимптотические распределения можно использовать для прогнозирования, проверки гипотез, построения других оценок и т. Д. В качестве примера рассмотрим проблему прогнозирования. Предположим это некоторая точка в области распределения регрессоров, и нужно знать, какой была бы переменная ответа в этой точке. В средний ответ это количество , тогда как предсказанный ответ является . Очевидно, что прогнозируемый ответ является случайной величиной, его распределение может быть получено из распределения :

что позволяет построить доверительные интервалы для среднего ответа будут построены:

- на 1 − α уровень уверенности.

Проверка гипотезы

Эта секция нуждается в расширении. Вы можете помочь добавляя к этому. (Февраль 2017 г.) |

Особенно широко используются две проверки гипотез. Во-первых, кто-то хочет знать, лучше ли оценочное уравнение регрессии, чем простое предсказание, что все значения переменной ответа равны ее выборочному среднему (если нет, то говорят, что оно не имеет объяснительной силы). В нулевая гипотеза отсутствие объяснительной ценности оцененной регрессии проверяется с использованием F-тест. Если вычисленное F-значение оказывается достаточно большим, чтобы превысить свое критическое значение для предварительно выбранного уровня значимости, нулевая гипотеза отклоняется и Альтернативная гипотеза, что регрессия имеет объяснительную силу, принимается. В противном случае принимается нулевая гипотеза об отсутствии объяснительной силы.

Во-вторых, для каждой интересующей объясняющей переменной нужно знать, значительно ли отличается ее оценочный коэффициент от нуля, то есть действительно ли эта конкретная независимая переменная имеет объяснительную силу при прогнозировании переменной отклика. Здесь нулевая гипотеза состоит в том, что истинный коэффициент равен нулю. Эта гипотеза проверяется вычислением коэффициента t-статистика, как отношение оценки коэффициента к его стандартная ошибка. Если t-статистика больше заданного значения, нулевая гипотеза отклоняется, и выясняется, что переменная имеет объяснительную силу, а ее коэффициент значительно отличается от нуля. В противном случае принимается нулевая гипотеза о нулевом значении истинного коэффициента.

В дополнение Чау-тест используется для проверки того, имеют ли две подвыборки одинаковые истинные значения коэффициентов. Сумма квадратов остатков регрессий для каждого из подмножеств и для объединенного набора данных сравнивается путем вычисления F-статистики; если это превышает критическое значение, нулевая гипотеза об отсутствии разницы между двумя подмножествами отклоняется; в противном случае принимается.

Пример с реальными данными

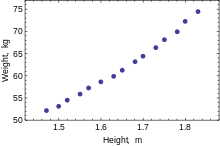

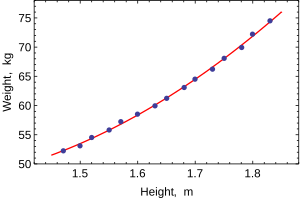

Следующий набор данных дает средние показатели роста и веса для американских женщин в возрасте 30–39 лет (источник: Всемирный альманах и книга фактов, 1975 г.).

Высота (м) 1.47 1.50 1.52 1.55 1.57 1.60 1.63 1.65 1.68 1.70 1.73 1.75 1.78 1.80 1.83 Вес (кг) 52.21 53.12 54.48 55.84 57.20 58.57 59.93 61.29 63.11 64.47 66.28 68.10 69.92 72.19 74.46

Когда моделируется только одна зависимая переменная, диаграмма рассеяния предложит форму и силу связи между зависимой переменной и регрессорами. Он также может выявить выбросы, гетероскедастичность и другие аспекты данных, которые могут усложнить интерпретацию подобранной регрессионной модели. Диаграмма рассеяния предполагает, что связь сильная и может быть аппроксимирована квадратичной функцией. OLS может обрабатывать нелинейные отношения, вводя регрессор РОСТ2. Затем регрессионная модель становится множественной линейной моделью:

Вывод из самых популярных статистические пакеты будет выглядеть примерно так:

Метод Наименьших квадратов Зависимая переменная ВЕС Наблюдения 15 Параметр Ценность Стандартная ошибка t-статистика p-значение 128.8128 16.3083 7.8986 0.0000 –143.1620 19.8332 –7.2183 0.0000 61.9603 6.0084 10.3122 0.0000 р2 0.9989 S.E. регресса 0.2516 Скорректированный R2 0.9987 Сумма кв. 692.61 Логарифмическая вероятность 1.0890 Остаточная сумма кв. 0.7595 Стат. Дурбина – Ватсона. 2.1013 Общая сумма кв. 693.37 Критерий Акаике 0.2548 F-статистика 5471.2 Критерий Шварца 0.3964 p-значение (F-stat) 0.0000

В этой таблице:

- В Ценность столбец дает оценки параметров методом наименьших квадратов βj

- В Стандартная ошибка столбец показывает стандартные ошибки оценки каждого коэффициента:

- В t-статистика и p-значение столбцы проверяют, может ли какой-либо из коэффициентов быть равным нулю. В т-статистика рассчитывается просто как . Если ошибки ε подчиняются нормальному распределению, т следует распределению Стьюдента. В более слабых условиях т асимптотически нормально. Большие значения т указывают, что нулевая гипотеза может быть отклонена и что соответствующий коэффициент не равен нулю.Второй столбец, п-ценность, выражает результаты проверки гипотезы как уровень значимости. Обычно п-значения меньше 0,05 принимаются как свидетельство того, что коэффициент генеральной совокупности не равен нулю.

- R-квадрат это коэффициент детерминации что указывает на соответствие регрессии. Эта статистика будет равна единице, если соответствие идеальное, и нулю, если регрессоры Икс не имеют никакой объяснительной силы. Это необъективная оценка населения. R-квадрат, и никогда не уменьшится при добавлении дополнительных регрессоров, даже если они не имеют значения.

- Скорректированный R-квадрат это слегка измененная версия , предназначенная для наказания за избыточное количество регрессоров, которые не увеличивают объяснительную силу регрессии. Эта статистика всегда меньше, чем , может уменьшаться при добавлении новых регрессоров и даже быть отрицательным для плохо подходящих моделей:

- Логарифмическая вероятность рассчитывается в предположении, что ошибки подчиняются нормальному распределению. Несмотря на то, что это предположение не очень разумно, эта статистика все же может найти свое применение при проведении LR-тестов.

- Статистика Дарбина – Ватсона проверяет, есть ли какие-либо доказательства серийной корреляции между остатками. Как показывает практика, значение меньше 2 будет свидетельством положительной корреляции.

- Информационный критерий Акаике и Критерий Шварца оба используются для выбора модели. Обычно при сравнении двух альтернативных моделей меньшие значения одного из этих критериев указывают на лучшую модель.[33]

- Стандартная ошибка регрессии это оценка σ, стандартная ошибка члена ошибки.

- Общая сумма квадратов, модельная сумма квадратов, и остаточная сумма квадратов расскажите нам, какая часть первоначального разброса в выборке была объяснена регрессией.

- F-статистика пытается проверить гипотезу о том, что все коэффициенты (кроме точки пересечения) равны нулю. Эта статистика F(p – 1,n – p) распределения при нулевой гипотезе и предположении нормальности, и его p-значение указывает на вероятность того, что гипотеза действительно верна. Обратите внимание, что когда ошибки не являются нормальными, эта статистика становится недействительной, и другие тесты, такие как Тест Вальда или LR тест должен быть использован.

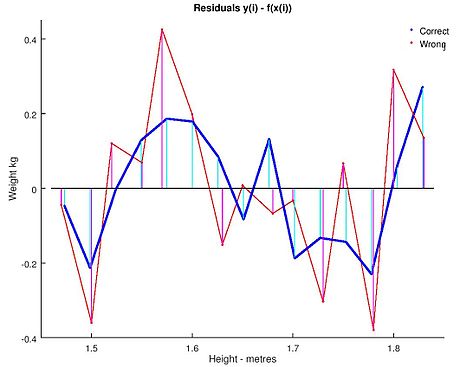

Обычный анализ методом наименьших квадратов часто включает использование диагностических графиков, предназначенных для обнаружения отклонений данных от предполагаемой формы модели. Вот некоторые из распространенных диагностических графиков:

- Остатки против независимых переменных в модели. Нелинейная связь между этими переменными предполагает, что линейность функции условного среднего может не выполняться. Различные уровни изменчивости остатков для разных уровней объясняющих переменных предполагают возможную гетероскедастичность.

- Остатки против объясняющих переменных, которых нет в модели. Любая связь остатков с этими переменными предполагает рассмотрение этих переменных для включения в модель.

- Остатки против установленных значений, .

- Остатки против предыдущего остатка. Этот график может идентифицировать серийные корреляции в остатках.

Важным моментом при выполнении статистического вывода с использованием регрессионных моделей является выборка данных. В этом примере данные являются средними, а не измерениями по отдельным женщинам. Подгонка модели очень хорошая, но это не означает, что вес отдельной женщины можно предсказать с высокой точностью только на основе ее роста.

Чувствительность к округлению

Этот пример также демонстрирует, что коэффициенты, определяемые этими вычислениями, чувствительны к способу подготовки данных. Первоначально высота была округлена до ближайшего дюйма, а затем преобразована и округлена до ближайшего сантиметра. Поскольку коэффициент преобразования составляет один дюйм на 2,54 см, это не точное преобразование. Исходные дюймы могут быть восстановлены с помощью функции Round (x / 0,0254), а затем преобразованы в метрическую систему без округления. Если это будет сделано, результаты станут:

| Const | Рост | Рост2 | |

|---|---|---|---|

| Преобразовано в метрическую систему с округлением. | 128.8128 | −143.162 | 61.96033 |

| Преобразуется в метрическую систему без округления. | 119.0205 | −131.5076 | 58.5046 |

Использование любого из этих уравнений для прогнозирования веса женщины ростом 5 футов 6 дюймов (1,6764 м) дает аналогичные значения: 62,94 кг с округлением по сравнению с 62,98 кг без округления. Таким образом, кажущиеся незначительными отклонения в данных реально влияют на коэффициенты. но небольшое влияние на результаты уравнения.

Хотя это может выглядеть безобидно в середине диапазона данных, оно может стать значимым в крайних случаях или в случае, когда подобранная модель используется для проецирования за пределы диапазона данных (экстраполяция ).

Это подчеркивает общую ошибку: этот пример представляет собой злоупотребление OLS, которое по своей сути требует, чтобы ошибки в независимой переменной (в данном случае высоте) были равны нулю или, по крайней мере, незначительны. Первоначальное округление до ближайшего дюйма плюс любые фактические ошибки измерения составляют конечную ошибку, которой нельзя пренебречь. В результате подобранные параметры не являются наилучшими оценками, как предполагалось. Хотя это и не является полностью ложным, ошибка в оценке будет зависеть от относительного размера Икс и y ошибки.

Другой пример с менее реальными данными

Постановка задачи

Мы можем использовать механизм наименьших квадратов, чтобы выяснить уравнение орбиты двух тел в полярных координатах. Обычно используется уравнение где - радиус, на котором объект находится от одного из тел. В уравнении параметры и используются для определения траектории орбиты. Мы измерили следующие данные.

| (в градусах) | 43 | 45 | 52 | 93 | 108 | 116 |

|---|---|---|---|---|---|---|

| 4.7126 | 4.5542 | 4.0419 | 2.2187 | 1.8910 | 1.7599 |

Нам нужно найти приближение наименьших квадратов и по приведенным данным.

Решение

Сначала нам нужно представить e и p в линейной форме. Итак, мы собираемся переписать уравнение так как . Теперь мы можем использовать эту форму для представления наших данных наблюдений как:

где является и является и строится по первому столбцу, являющемуся коэффициентом а второй столбец - коэффициент при и - значения для соответствующих так и

При решении получаем

так и

Смотрите также

- Байесовский метод наименьших квадратов

- Регрессия Фамы – Макбета

- Нелинейный метод наименьших квадратов

- Численные методы линейных наименьших квадратов

- Идентификация нелинейной системы

использованная литература

- ^ Гольдбергер, Артур С. (1964). «Классическая линейная регрессия». Эконометрическая теория. Нью-Йорк: Джон Вили и сыновья. стр.158. ISBN 0-471-31101-4.

- ^ Хаяси, Фумио (2000). Эконометика. Издательство Принстонского университета. п. 15.CS1 maint: ref = harv (ссылка на сайт)

- ^ Хаяси (2000), стр.18)

- ^ [1]

- ^ [2]

- ^ [3]

- ^ а б Хаяси (2000), стр.19)

- ^ Джулиан Фарауэй (2000), Практическая регрессия и Anova с использованием R

- ^ Kenney, J .; Удерживая, Э. С. (1963). Математика статистики. ван Ностранд. п. 187.

- ^ Цвиллинджер, Д. (1995). Стандартные математические таблицы и формулы. Чепмен и Холл / CRC. п. 626. ISBN 0-8493-2479-3.

- ^ Хаяси (2000), стр.20)

- ^ Хаяси (2000), стр.5)

- ^ Акбарзаде, Вахаб. «Оценка линии».

- ^ Хаяси (2000), стр.49)

- ^ а б Хаяси (2000), стр. 52)

- ^ Хаяси (2000), стр.7)

- ^ Хаяси (2000), стр.187)

- ^ а б Хаяси (2000), стр.10)

- ^ Хаяси (2000), стр. 34)

- ^ Уильямс, М. Н; Grajales, C.A.G; Куркевич, Д. (2013). «Предположения множественной регрессии: исправление двух заблуждений». Практическая оценка, исследования и оценка. 18 (11).

- ^ Хаяси (2000), страницы 27, 30)

- ^ а б c Хаяси (2000), стр.27)

- ^ Амемия, Такеши (1985). Продвинутая эконометрика. Издательство Гарвардского университета. п.13.CS1 maint: ref = harv (ссылка на сайт)

- ^ Амемия (1985, стр.14)

- ^ Рао, К. (1973). Линейный статистический вывод и его приложения (Второе изд.). Нью-Йорк: J. Wiley & Sons. п. 319. ISBN 0-471-70823-2.

- ^ Амемия (1985, стр.20)

- ^ Амемия (1985, стр.27)

- ^ а б Дэвидсон, Рассел; Маккиннон, Джеймс Г. (1993). Оценка и вывод в эконометрике. Нью-Йорк: Издательство Оксфордского университета. п. 33. ISBN 0-19-506011-3.CS1 maint: ref = harv (ссылка на сайт)

- ^ Дэвидсон и Маккиннон (1993, стр.36)

- ^ Дэвидсон и Маккиннон (1993, стр.20)

- ^ Амемия (1985, стр.21)

- ^ а б Амемия (1985, стр.22)

- ^ Burnham, Kenneth P .; Дэвид Андерсон (2002). Выбор модели и многомодельный вывод (2-е изд.). Springer. ISBN 0-387-95364-7.

дальнейшее чтение

- Догерти, Кристофер (2002). Введение в эконометрику (2-е изд.). Нью-Йорк: Издательство Оксфордского университета. С. 48–113. ISBN 0-19-877643-8.

- Гуджарати, Дамодар Н.; Портер, Дон С. (2009). Основы эконометики (Пятое изд.). Бостон: Макгроу-Хилл Ирвин. С. 55–96. ISBN 978-0-07-337577-9.

- Хилл, Р. Картер; Гриффитс, Уильям Э .; Лим, Гуай С. (2008). Принципы эконометрики (3-е изд.). Хобокен, Нью-Джерси: Джон Уайли и сыновья. С. 8–47. ISBN 978-0-471-72360-8.

- Вулдридж, Джеффри (2008). «Модель простой регрессии». Вводная эконометрика: современный подход (4-е изд.). Мейсон, Огайо: Обучение Cengage. С. 22–67. ISBN 978-0-324-58162-1.

![{ displaystyle { begin {align} { hat { beta}} & = { frac { sum {x_ {i} y_ {i}} - { frac {1} {n}} sum {x_ {i}} sum {y_ {i}}} { sum {x_ {i} ^ {2}} - { frac {1} {n}} ( sum {x_ {i}}) ^ {2 }}} = { frac { operatorname {Cov} [x, y]} { operatorname {Var} [x]}} { hat { alpha}} & = { overline {y}} - { hat { beta}} , { overline {x}} , end {выравнивается}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/817c4939058094674f0ef2787ef175b5c7170c07)

![[X K]](https://wikimedia.org/api/rest_v1/media/math/render/svg/b0c7583e31f8e4111806d1612b81b39d3f76af01)

![mathrm {E} { big [} , x_ {i} (y_ {i} -x_ {i} ^ {T} beta) , { big]} = 0.](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb1a1f1cb2be7e80f44761892bf788fe2b2af548)

![{ displaystyle operatorname {E} [, varepsilon mid X ,] = 0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dcdfa07f07180573874658708bc2a889d5416199)

![Pr ! { Big [} , operatorname {rank} (X) = p , { big]} = 1.](https://wikimedia.org/api/rest_v1/media/math/render/svg/6a11be3b89ce51c6441155fddbe512a991132fbf)

![operatorname {Var} [, varepsilon mid X ,] = sigma ^ {2} I_ {n},](https://wikimedia.org/api/rest_v1/media/math/render/svg/0df70427bd7e0b69175caf9150b2d465dd152474)

![operatorname {E} [, { hat { beta}} mid X ,] = beta, quad operatorname {E} [, s ^ {2} mid X ,] = sigma ^ {2}.](https://wikimedia.org/api/rest_v1/media/math/render/svg/67bc2fd0f90c46da207712893fdcea01e729026c)

![{ displaystyle operatorname {Var} [, { hat { beta}} mid X ,] = sigma ^ {2} (X ^ {T} X) ^ {- 1} = sigma ^ { 2} Q.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f96b58e87986e32ad2375a1db34fb64a7a16e2f)

![operatorname {Cov} [, { hat { beta}}, { hat { varepsilon}} mid X ,] = 0.](https://wikimedia.org/api/rest_v1/media/math/render/svg/664c1a5e37957a1aa2ae381b9bcb07350c2c816c)

![operatorname {Var} [, { tilde { beta}} mid X ,] - operatorname {Var} [, { hat { beta}} mid X ,] geq 0](https://wikimedia.org/api/rest_v1/media/math/render/svg/53796c9205889cc4d675b9749a58eb97fcd998f1)

![{ displaystyle beta _ {j} in { bigg [} { hat { beta}} _ {j} pm q_ {1 - { frac { alpha} {2}}} ^ {{ mathcal {N}} (0,1)} ! { sqrt {{ hat { sigma}} ^ {2} left [Q_ {xx} ^ {- 1} right] _ {jj}} } { bigg]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cf79688aac9f662ff39253fbfb0d234246d370e5)

![{ displaystyle ({ hat { sigma}} ^ {2} - sigma ^ {2}) { xrightarrow {d}} { mathcal {N}} left (0, ; operatorname { E} left [ varepsilon _ {i} ^ {4} right] - sigma ^ {4} right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7c909dea2a4f0bf40e253680b953d1bfbb66298f)

![{ displaystyle y_ {0} in left [ x_ {0} ^ { mathrm {T}} { hat { beta}} pm q_ {1 - { frac { alpha} {2}} } ^ {{ mathcal {N}} (0,1)} ! { sqrt {{ hat { sigma}} ^ {2} x_ {0} ^ { mathrm {T}} Q_ {xx} ^ {- 1} x_ {0}}} right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cf86d7a311c97d35fb6e039c3cd74bc9f3e752bf)

![{ displaystyle { hat { sigma}} _ {j} = left ({ hat { sigma}} ^ {2} left [Q_ {xx} ^ {- 1} right] _ {jj} right) ^ { frac {1} {2}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5087e66171bf3ef9ad3ac75decdd715274919669)