Наименьших квадратов - Least squares

| Часть серии по |

| Регрессивный анализ |

|---|

|

| Модели |

| Предварительный расчет |

| Задний план |

|

Методика наименьших квадратов стандартный подход в регрессивный анализ аппроксимировать решение сверхдетерминированные системы (системы уравнений, в которых больше уравнений, чем неизвестных) путем минимизации суммы квадратов остатков, полученных в результате каждого отдельного уравнения.

Самое важное приложение находится в подбор данных. Наилучшее соответствие в смысле наименьших квадратов минимизирует сумма квадратов остатки (остаточное существо: разница между наблюдаемым значением и подобранным значением, предоставленным моделью). Когда проблема имеет существенные неопределенности в независимая переменная (в Икс переменная), то у простых методов регрессии и наименьших квадратов есть проблемы; в таких случаях методика, необходимая для установки модели ошибок в переменных может использоваться вместо метода наименьших квадратов.

Задачи наименьших квадратов делятся на две категории: линейные и обыкновенный метод наименьших квадратов и нелинейный метод наименьших квадратов, в зависимости от того, являются ли невязки линейными по всем неизвестным. Линейная задача наименьших квадратов возникает в статистической регрессивный анализ; оно имеет закрытое решение. Нелинейная задача обычно решается итеративным уточнением; на каждой итерации система аппроксимируется линейной, поэтому расчет керна в обоих случаях одинаков.

Полиномиальные наименьшие квадраты описывает дисперсию предсказания зависимой переменной как функцию независимой переменной и отклонения от подобранной кривой.

Когда наблюдения приходят из экспоненциальная семья и мягкие условия выполнены, оценки методом наименьших квадратов и максимальная вероятность оценки идентичны.[1] Метод наименьших квадратов также может быть получен как метод моментов оценщик.

Следующее обсуждение в основном представлено с точки зрения линейный функций, но использование наименьших квадратов действительно и практично для более общих семейств функций. Кроме того, итеративно применяя локальное квадратичное приближение к правдоподобию (через Информация Fisher ), можно использовать метод наименьших квадратов для подбора обобщенная линейная модель.

Метод наименьших квадратов был официально открыт и опубликован Адриан-Мари Лежандр (1805),[2] хотя обычно он также приписывается Карл Фридрих Гаусс (1795)[3][4] который внес значительный теоретический прогресс в этот метод и, возможно, ранее использовал его в своей работе.[5][6]

История

Основание

Метод наименьших квадратов вырос из областей астрономия и геодезия, поскольку ученые и математики стремились найти решения проблем навигации по океанам Земли во время Эпоха исследований. Точное описание поведения небесных тел было ключом к тому, чтобы корабли могли плавать в открытом море, где моряки больше не могли полагаться на наземные наблюдения для навигации.

Этот метод стал кульминацией нескольких достижений, имевших место в течение восемнадцатого века:[7]

- Комбинация различных наблюдений как лучшая оценка истинного значения; ошибки уменьшаются с агрегированием, а не увеличиваются, возможно, сначала выражаются Роджер Котс в 1722 г.

- Комбинация различных наблюдений, сделанных в такой же условия, а не просто попытки изо всех сил точно наблюдать и записывать одно наблюдение. Этот подход был известен как метод средних. Этот подход, в частности, использовался Тобиас Майер во время изучения либрации Луны в 1750 году, и Пьер-Симон Лаплас в своей работе по объяснению различий в движении Юпитер и Сатурн в 1788 г.

- Комбинация различных наблюдений, сделанных другой условия. Этот метод стал известен как метод наименьшего абсолютного отклонения. Это было заметно исполнено Роджер Джозеф Боскович в своей работе о форме земли в 1757 г. Пьер-Симон Лаплас для той же задачи в 1799 г.

- Разработка критерия, который может быть оценен, чтобы определить, когда было достигнуто решение с минимальной ошибкой. Лаплас попытался определить математическую форму вероятность плотность ошибок и определить метод оценки, который минимизирует ошибку оценки. Для этой цели Лаплас использовал симметричное двустороннее экспоненциальное распределение, которое мы теперь называем Распределение Лапласа для моделирования распределения ошибок и использовали сумму абсолютных отклонений в качестве ошибки оценки. Он чувствовал, что это самые простые предположения, которые он мог сделать, и надеялся получить среднее арифметическое как наилучшую оценку. Вместо этого его оценкой была апостериорная медиана.

Метод

Первое ясное и лаконичное изложение метода наименьших квадратов было опубликовано Legendre в 1805 г.[8] Этот метод описывается как алгебраическая процедура подгонки линейных уравнений к данным, и Лежандр демонстрирует новый метод, анализируя те же данные, что и Лаплас, для формы Земли. Ценность метода наименьших квадратов Лежандра была немедленно признана ведущими астрономами и геодезистами того времени.[нужна цитата ]

В 1809 г. Карл Фридрих Гаусс опубликовал свой метод расчета орбит небесных тел. В этой работе он утверждал, что владеет методом наименьших квадратов с 1795 года. Это, естественно, привело к спору о приоритете с Лежандром. Однако, к чести Гаусса, он вышел за рамки Лежандра и сумел связать метод наименьших квадратов с принципами вероятности и нормальное распределение. Ему удалось завершить программу Лапласа по определению математической формы плотности вероятности для наблюдений, зависящей от конечного числа неизвестных параметров, и определить метод оценки, который минимизирует ошибку оценки. Гаусс показал, что среднее арифметическое действительно является наилучшей оценкой параметра местоположения путем изменения как плотность вероятности и метод оценки. Затем он решил проблему, задав вопрос, какую форму должна иметь плотность и какой метод оценки следует использовать, чтобы получить среднее арифметическое значение в качестве оценки параметра местоположения. В этой попытке он изобрел нормальное распределение.

Ранняя демонстрация силы Метод Гаусса пришел, когда его использовали для предсказания будущего местоположения недавно открытого астероида Церера. 1 января 1801 года итальянский астроном Джузеппе Пьяцци обнаружил Цереру и смог проследить ее путь в течение 40 дней, прежде чем он затерялся в ярком солнечном свете. Основываясь на этих данных, астрономы хотели определить местоположение Цереры после того, как она появилась из-за Солнца, не решая Сложные нелинейные уравнения Кеплера планетарного движения. Единственные предсказания, которые позволили венгерскому астроному Франц Ксавер фон Зак Перемещение Цереры было выполнено 24-летним Гауссом с использованием анализа наименьших квадратов.

В 1810 году, прочитав работу Гаусса, Лаплас, доказав Центральная предельная теорема, использовал его для обоснования большой выборки метода наименьших квадратов и нормального распределения. В 1822 году Гаусс смог заявить, что подход наименьших квадратов к регрессионному анализу является оптимальным в том смысле, что в линейной модели, где ошибки имеют нулевое среднее значение, некоррелированы и имеют равные дисперсии, наилучшая линейная несмещенная оценка коэффициенты - это оценка методом наименьших квадратов. Этот результат известен как Теорема Гаусса – Маркова.

Идея анализа методом наименьших квадратов была независимо сформулирована американским исследователем. Роберт Адрейн в 1808 г. В последующие два столетия специалисты по теории ошибок и статистике нашли много различных способов применения метода наименьших квадратов.[9]

Постановка задачи

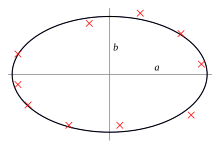

Цель состоит в настройке параметров модельной функции для наилучшего соответствия набору данных. Простой набор данных состоит из п точки (пары данных) , я = 1, ..., п, где является независимая переменная и это зависимая переменная значение которого определяется наблюдением. Модельная функция имеет вид , где м настраиваемые параметры хранятся в векторе . Цель состоит в том, чтобы найти значения параметров для модели, которые "наилучшим образом" соответствуют данным. Подгонка модели к точке данных измеряется ее остаточный, определяемый как разница между фактическим значением зависимой переменной и значением, предсказанным моделью:

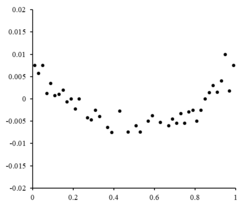

Остатки нанесены на соответствующие графики. ценности. Случайные колебания около указать, что линейная модель подходит.

Остатки нанесены на соответствующие графики. ценности. Случайные колебания около указать, что линейная модель подходит.

Метод наименьших квадратов находит оптимальные значения параметров, минимизируя сумму, , квадратов остатков:

Примером модели в двух измерениях является прямая линия. Обозначая точку пересечения оси Y как и наклон как , модельная функция имеет вид . Увидеть линейный метод наименьших квадратов за полностью проработанный пример этой модели.

Точка данных может состоять из более чем одной независимой переменной. Например, при подгонке плоскости к набору измерений высоты плоскость является функцией двух независимых переменных: Икс и z, сказать. В наиболее общем случае в каждой точке данных может быть одна или несколько независимых переменных и одна или несколько зависимых переменных.

Справа - остаточный график, иллюстрирующий случайные колебания относительно , что указывает на то, что линейная модель Уместно. является независимой случайной величиной.[10]

Если бы остаточные точки имели некоторую форму и не колебались случайным образом, линейная модель не подходила бы. Например, если остаточный график имел параболическую форму, если смотреть справа, параболическая модель подойдет для данных. Остатки для параболической модели могут быть рассчитаны с помощью .[10]

Ограничения

Эта формулировка регрессии учитывает только ошибки наблюдений в зависимой переменной (но альтернативный вариант Всего наименьших квадратов регрессия может учитывать ошибки в обеих переменных). Есть два довольно разных контекста с разными значениями:

- Регрессия для предсказания. Здесь модель подбирается для обеспечения правила прогнозирования для применения в аналогичной ситуации, к которой применяются данные, используемые для подгонки. Здесь зависимые переменные, соответствующие такому будущему применению, будут подвержены тем же типам ошибок наблюдения, что и в данных, используемых для подгонки. Следовательно, для таких данных логически целесообразно использовать правило прогнозирования методом наименьших квадратов.

- Регрессия для подбора «истинных отношений». В стандартной регрессивный анализ что приводит к аппроксимации методом наименьших квадратов, существует неявное предположение, что ошибки в независимая переменная равны нулю или строго контролируются, чтобы ими можно было пренебречь. Когда ошибки в независимая переменная не пренебрежимо малы, модели погрешности измерения может быть использован; такие методы могут привести к оценки параметров, проверка гипотезы и доверительные интервалы которые учитывают наличие ошибок наблюдения в независимых переменных.[11] Альтернативный подход - подгонка модели Всего наименьших квадратов; это можно рассматривать как использование прагматического подхода к уравновешиванию эффектов различных источников ошибок при формулировании целевой функции для использования при подборе модели.

Решение задачи наименьших квадратов

В минимум суммы квадратов находится установкой градиент до нуля. Поскольку модель содержит м параметры, есть м уравнения градиента:

и с тех пор , градиентные уравнения принимают вид

Уравнения градиента применимы ко всем задачам наименьших квадратов. Каждая конкретная проблема требует определенных выражений для модели и ее частных производных.[12]

Линейный метод наименьших квадратов

Регрессионная модель является линейной, когда модель содержит линейная комбинация параметров, т.е.

где функция является функцией .[12]

Сдача и помещая независимые и зависимые переменные в матрицы и мы можем вычислить наименьшие квадраты следующим образом, обратите внимание, что это набор всех данных. [12][13]

Нахождение минимума может быть достигнуто путем установки градиента потерь на ноль и решения для

Наконец, установив градиент потерь на ноль и решив для мы получаем: [13][12]

Нелинейный метод наименьших квадратов

В некоторых случаях закрытое решение к нелинейной задаче наименьших квадратов - но в общем случае нет. В случае отсутствия решения в закрытой форме используются численные алгоритмы для нахождения значений параметров. что сводит к минимуму цель. Большинство алгоритмов включают выбор начальных значений параметров. Затем параметры уточняются итеративно, то есть значения получаются методом последовательного приближения:

где верхний индекс k - номер итерации, а вектор приращений называется вектором сдвига. В некоторых обычно используемых алгоритмах на каждой итерации модель может быть линеаризована путем приближения к первому порядку. Серия Тейлор расширение о :

В Якобиан J является функцией констант, независимая переменная и параметры, поэтому он меняется от одной итерации к другой. Остатки даются как

Чтобы минимизировать сумму квадратов , градиентное уравнение устанавливается равным нулю и решается для :

которые при перестановке становятся м совместных линейных уравнений, нормальные уравнения:

Нормальные уравнения записываются в матричных обозначениях как

Это определяющие уравнения Алгоритм Гаусса – Ньютона.

Различия между линейным и нелинейным методом наименьших квадратов

- Модельная функция, ж, в LLSQ (линейный метод наименьших квадратов) - линейная комбинация параметров вида Модель может представлять собой прямую линию, параболу или любую другую линейную комбинацию функций. В NLLSQ (нелинейный метод наименьших квадратов) параметры отображаются как функции, например и так далее. Если производные либо постоянны, либо зависят только от значений независимой переменной, модель линейна по параметрам. В противном случае модель будет нелинейной.

- Требуются начальные значения для параметров, чтобы найти решение проблемы NLLSQ; LLSQ не требует их.

- Алгоритмы решения для NLLSQ часто требуют, чтобы якобиан мог быть вычислен аналогично LLSQ. Аналитические выражения для частных производных могут быть сложными. Если аналитические выражения получить невозможно, либо частные производные должны быть вычислены с помощью численного приближения, либо должна быть сделана оценка якобиана, часто через конечные разности.

- Несходимость (неспособность алгоритма найти минимум) - обычное явление в NLLSQ.

- LLSQ является глобально вогнутым, поэтому несходимость не является проблемой.

- Решение NLLSQ обычно является итеративным процессом, который должен быть прекращен, когда выполняется критерий сходимости. Решения LLSQ могут быть вычислены с использованием прямых методов, хотя проблемы с большим количеством параметров обычно решаются с помощью итерационных методов, таких как Гаусс-Зейдель метод.

- В LLSQ решение уникально, но в NLLSQ может быть несколько минимумов в сумме квадратов.

- При условии, что ошибки не коррелируют с переменными-предсказателями, LLSQ дает несмещенные оценки, но даже при этом условии оценки NLLSQ обычно смещены.

Эти различия необходимо учитывать всякий раз, когда ищется решение нелинейной задачи наименьших квадратов.[12]

Регрессионный анализ и статистика

Метод наименьших квадратов часто используется для создания оценок и другой статистики в регрессионном анализе.

Рассмотрим простой пример из физики. Пружина должна подчиняться Закон Гука который утверждает, что расширение пружины у пропорциональна силе, F, применительно к нему.

составляет модель, где F - независимая переменная. Чтобы оценить силовая постоянная, k, мы проводим серию п измерения с разными усилиями для получения набора данных, , где уя размерное растяжение пружины.[14] Каждое экспериментальное наблюдение будет содержать некоторую ошибку, , и поэтому мы можем указать эмпирическую модель для наших наблюдений,

Есть много методов, которые мы можем использовать для оценки неизвестного параметра. k. Поскольку п уравнения в м переменные в наших данных составляют сверхдетерминированная система с одним неизвестным и п уравнения, оценим k методом наименьших квадратов. Минимизируемая сумма квадратов равна

Оценка силовой постоянной методом наименьших квадратов, k, дан кем-то

Мы предполагаем, что приложение силы причины пружина для расширения. После получения силовой постоянной методом наименьших квадратов мы прогнозируем расширение по закону Гука.

Исследователь определяет эмпирическую модель в регрессионном анализе. Очень распространенной моделью является модель прямой линии, которая используется для проверки наличия линейной связи между независимыми и зависимыми переменными. Переменные называются коррелированный если существует линейная связь. Однако, корреляция не доказывает причинно-следственную связь, поскольку обе переменные могут быть коррелированы с другими, скрытыми переменными, или зависимая переменная может "обратить" причину независимых переменных, или переменные могут быть иным образом ложно коррелированы. Например, предположим, что существует корреляция между смертностью от утопления и объемом продаж мороженого на определенном пляже.Тем не менее, как количество людей, идущих купаться, так и объем продаж мороженого увеличиваются по мере того, как становится жарче, и, по-видимому, количество смертей от утопления коррелирует с количеством людей, идущих купаться. Возможно, что увеличение числа пловцов приводит к увеличению обеих других переменных.

Для статистической проверки результатов необходимо сделать предположения о природе экспериментальных ошибок. Распространенным предположением является то, что ошибки принадлежат нормальному распределению. В Центральная предельная теорема поддерживает идею о том, что во многих случаях это хорошее приближение.

- В Теорема Гаусса – Маркова. В линейной модели, в которой ошибки имеют ожидание нулевые условные на независимых переменных, являются некоррелированный и иметь равные отклонения, лучший линейный беспристрастный Оценка любой линейной комбинации наблюдений является ее оценкой методом наименьших квадратов. «Наилучшее» означает, что оценки параметров методом наименьших квадратов имеют минимальную дисперсию. Предположение о равной дисперсии действительно, когда все ошибки принадлежат одному и тому же распределению.

- В линейной модели, если ошибки принадлежат нормальному распределению, оценки наименьших квадратов также являются оценщики максимального правдоподобия.

Однако, если ошибки не имеют нормального распределения, Центральная предельная теорема часто тем не менее подразумевает, что оценки параметров будут приблизительно нормально распределены, если выборка достаточно велика. По этой причине, учитывая важное свойство, заключающееся в том, что среднее значение ошибки не зависит от независимых переменных, распределение члена ошибки не является важным вопросом в регрессионном анализе. В частности, обычно не важно, следует ли член ошибки нормальному распределению.

При расчете методом наименьших квадратов с единичными весами или в линейной регрессии дисперсия j-й параметр, обозначенный , обычно оценивается

где истинная дисперсия ошибок σ2 заменяется оценкой, основанной на минимизированном значении целевой функции суммы квадратов S. Знаменатель, п − м, это статистические степени свободы; увидеть эффективные степени свободы для обобщений.[12]

Если распределение вероятностей параметров известна или сделана асимптотическая аппроксимация, пределы уверенности может быть найден. Точно так же можно провести статистические тесты остатков, если распределение вероятностей остатков известно или предполагается. Мы можем получить распределение вероятностей любой линейной комбинации зависимых переменных, если распределение вероятностей экспериментальных ошибок известно или предполагается. Сделать вывод легко, если предположить, что ошибки следуют нормальному распределению, следовательно, подразумевая, что оценки параметров и остатки также будут нормально распределены в зависимости от значений независимых переменных.[12]

Взвешенный метод наименьших квадратов

Частный случай обобщенный метод наименьших квадратов называется взвешенный метод наименьших квадратов происходит, когда все недиагональные записи Ω (корреляционная матрица остатков) равны нулю; то отклонения наблюдений (по диагонали ковариационной матрицы) все еще могут быть неравными (гетероскедастичность ). Проще говоря, гетероскедастичность это когда дисперсия зависит от стоимости что приводит к тому, что остаточный сюжет создает эффект "разветвления" в сторону большего значения, как показано на остаточном графике справа. С другой стороны, гомоскедастичность предполагает, что дисперсия и равно.[10]

Отношение к основным компонентам

Первый главный компонент о среднем значении набора точек может быть представлено той линией, которая наиболее близко приближается к точкам данных (измеряется квадратом расстояния ближайшего сближения, т. е. перпендикулярно линии). Напротив, линейный метод наименьших квадратов пытается минимизировать расстояние в только направление. Таким образом, хотя оба используют схожую метрику ошибки, линейный метод наименьших квадратов - это метод, который предпочтительно обрабатывает одно измерение данных, тогда как PCA обрабатывает все измерения одинаково.

Регуляризация

Эта секция может быть слишком техническим для большинства читателей, чтобы понять. Пожалуйста помогите улучшить это к сделать понятным для неспециалистов, не снимая технических деталей. (Февраль 2016 г.) (Узнайте, как и когда удалить этот шаблон сообщения) |

Тихоновская регуляризация

В некоторых контекстах упорядоченный вариант решения наименьших квадратов может быть предпочтительнее. Тихоновская регуляризация (или регресс гребня ) добавляет ограничение, которое , то L2-норма вектора параметров не больше заданного значения.[нужна цитата ] Эквивалентно,[сомнительный ] он может решить неограниченную минимизацию штрафа наименьших квадратов с добавлено, где - константа (это Лагранжиан форма ограниченной задачи). В Байесовский в контексте, это эквивалентно размещению нормально распределенного предшествующий на векторе параметров.

Метод лассо

Альтернатива упорядоченный версия наименьших квадратов Лассо (оператор наименьшего абсолютного сжатия и выбора), который использует ограничение, которое , то L1-норма вектора параметров не больше заданного значения.[15][16][17] (Как и выше, это эквивалентно[сомнительный ] к неограниченной минимизации штрафа наименьших квадратов с добавлен.) Байесовский контекст, это эквивалентно размещению нулевого среднего Лаплас предварительное распространение на векторе параметров.[18] Проблему оптимизации можно решить с помощью квадратичное программирование или более общий выпуклая оптимизация методы, а также специальные алгоритмы, такие как наименьшая угловая регрессия алгоритм.

Одно из основных различий между лассо и регрессией гребня заключается в том, что в регрессии гребня при увеличении штрафа все параметры уменьшаются, но все еще остаются ненулевыми, в то время как в лассо увеличение штрафа приведет к тому, что все больше и больше параметров будут доведен до нуля. Это преимущество лассо перед регрессией гребня, так как приведение параметров к нулю отменяет выбор объектов из регрессии. Таким образом, Lasso автоматически выбирает более релевантные функции и отбрасывает другие, тогда как регрессия Ridge никогда полностью не отбрасывает какие-либо функции. Немного выбор функции методы разработаны на основе LASSO, включая Bolasso, который загружает образцы,[19] и FeaLect, который анализирует коэффициенты регрессии, соответствующие различным значениям чтобы оценить все особенности.[20]

L1-регуляризованная формулировка полезна в некоторых контекстах из-за ее тенденции отдавать предпочтение решениям, в которых большее количество параметров равно нулю, что дает решения, которые зависят от меньшего числа переменных.[15] По этой причине лассо и его варианты имеют основополагающее значение в области сжатое зондирование. Расширением этого подхода является эластичная чистая регуляризация.

Смотрите также

- Корректировка наблюдений

- Байесовская оценка MMSE

- Лучшая линейная несмещенная оценка (СИНИЙ)

- Лучший линейный объективный прогноз (BLUP)

- Теорема Гаусса – Маркова

- L2 норма

- Наименьшее абсолютное отклонение

- Погрешность измерения

- Ортогональная проекция

- Методы проксимального градиента для обучения

- Квадратичная функция потерь

- Среднеквадратичное значение

- Квадратные отклонения

использованная литература

- ^ Charnes, A .; Frome, E.L .; Ю. П. Л. (1976). «Эквивалентность обобщенных наименьших квадратов и оценок максимального правдоподобия в экспоненциальной семье». Журнал Американской статистической ассоциации. 71 (353): 169–171. Дои:10.1080/01621459.1976.10481508.

- ^ Мэнсфилд Мерриман, "Список работ, относящихся к методу наименьших квадратов"

- ^ Бретчер, Отто (1995). Линейная алгебра с приложениями (3-е изд.). Река Аппер Сэдл, Нью-Джерси: Prentice Hall.

- ^ Стиглер, Стивен М. (1981). «Гаусс и изобретение наименьших квадратов». Анна. Стат. 9 (3): 465–474. Дои:10.1214 / aos / 1176345451.

- ^ Британника, "Метод наименьших квадратов"

- ^ Исследования по истории вероятности и статистики. XXIX: Открытие метода наименьших квадратов Р. Л. Плэкетт

- ^ Стиглер, Стивен М. (1986). История статистики: измерение неопределенности до 1900 г.. Кембридж, Массачусетс: Belknap Press издательства Гарвардского университета. ISBN 978-0-674-40340-6.

- ^ Лежандр, Адриан-Мари (1805), Новые методы определения орбиты комет [Новые методы определения орбит комет] (на французском языке), Париж: Ф. Дидо

- ^ Олдрич, Дж. (1998). «Делая наименьшие квадраты: перспективы Гаусса и Йоля». Международный статистический обзор. 66 (1): 61–81. Дои:10.1111 / j.1751-5823.1998.tb00406.x.

- ^ а б c d Современное введение в вероятность и статистику: понимание, почему и как. Деккинг, Мишель, 1946-. Лондон: Спрингер. 2005 г. ISBN 978-1-85233-896-1. OCLC 262680588.CS1 maint: другие (ссылка на сайт)

- ^ Чтобы получить хорошее представление об ошибках в переменных, см. Фуллер, В.А. (1987). Модели ошибок измерения. Джон Вили и сыновья. ISBN 978-0-471-86187-4.

- ^ а б c d е ж г час Уильямс, Джеффри Х. (Джеффри Хью), 1956- (ноябрь 2016). Количественное измерение: тирания чисел. Издательство Morgan & Claypool Publishers, Институт физики (Великобритания). Сан-Рафаэль [Калифорния] (40 Оук Драйв, Сан-Рафаэль, Калифорния, 94903, США). ISBN 978-1-68174-433-9. OCLC 962422324.CS1 maint: несколько имен: список авторов (ссылка на сайт) CS1 maint: location (ссылка на сайт)

- ^ а б Rencher, Alvin C .; Кристенсен, Уильям Ф. (2012-08-15). Методы многомерного анализа. Джон Вили и сыновья. п. 155. ISBN 978-1-118-39167-9.

- ^ Гир, Джеймс М. (2013). Механика материалов. Гудно, Барри Дж. (8-е изд.). Стэмфорд, штат Коннектикут: Cengage Learning. ISBN 978-1-111-57773-5. OCLC 741541348.

- ^ а б Тибширани, Р. (1996). «Регрессионное сжатие и отбор с помощью лассо». Журнал Королевского статистического общества, серия B. 58 (1): 267–288. JSTOR 2346178.

- ^ Хасти, Тревор; Тибширани, Роберт; Фридман, Джером Х. (2009). Элементы статистического обучения (второе изд.). Springer-Verlag. ISBN 978-0-387-84858-7. Архивировано из оригинал на 2009-11-10.

- ^ Бюльманн, Питер; ван де Гир, Сара (2011). Статистика для многомерных данных: методы, теория и приложения. Springer. ISBN 9783642201929.

- ^ Парк, Тревор; Казелла, Джордж (2008). «Байесовское лассо». Журнал Американской статистической ассоциации. 103 (482): 681–686. Дои:10.1198/016214508000000337. S2CID 11797924.

- ^ Бах, Фрэнсис R (2008). «Болассо: модель согласованной оценки лассо с помощью бутстрапа». Материалы 25-й Международной конференции по машинному обучению: 33–40. arXiv:0804.1302. Bibcode:2008arXiv0804.1302B. Дои:10.1145/1390156.1390161. ISBN 9781605582054. S2CID 609778.

- ^ Заре, Хабил (2013). «Оценка релевантности функций на основе комбинаторного анализа Лассо с применением для диагностики лимфомы». BMC Genomics. 14: S14. Дои:10.1186 / 1471-2164-14-S1-S14. ЧВК 3549810. PMID 23369194.

дальнейшее чтение

- Бьорк, Å. (1996). Численные методы решения задач наименьших квадратов. СИАМ. ISBN 978-0-89871-360-2.

- Кария, Т .; Курата, Х. (2004). Обобщенные наименьшие квадраты. Хобокен: Вайли. ISBN 978-0-470-86697-9.

- Люенбергер, Д. (1997) [1969]. «Оценка методом наименьших квадратов». Оптимизация методами векторного пространства. Нью-Йорк: Джон Вили и сыновья. С. 78–102. ISBN 978-0-471-18117-0.

- Рао, К.; Тутенбург, Х.; и другие. (2008). Линейные модели: наименьшие квадраты и альтернативы. Серия Спрингера в статистике (3-е изд.). Берлин: Springer. ISBN 978-3-540-74226-5.

- Вольберг, Дж. (2005). Анализ данных методом наименьших квадратов: извлечение максимальной информации из экспериментов. Берлин: Springer. ISBN 978-3-540-25674-8.

внешние ссылки

СМИ, связанные с Наименьших квадратов в Wikimedia Commons

СМИ, связанные с Наименьших квадратов в Wikimedia Commons

![{ displaystyle operatorname {var} ({ hat { beta}} _ {j}) = sigma ^ {2} ([X ^ {T} X] ^ {- 1}) _ {jj} приблизительно { frac {S} {nm}} ([X ^ {T} X] ^ {- 1}) _ {jj},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f77b192f37c6a5f592a7e5b0601ec7fa95b6703d)