Максимальная апостериорная оценка - Maximum a posteriori estimation

Эта статья нужны дополнительные цитаты для проверка. (Сентябрь 2011 г.) (Узнайте, как и когда удалить этот шаблон сообщения) |

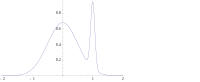

В Байесовская статистика, а максимальная апостериорная вероятность (КАРТА) оценивать оценка неизвестной величины, которая равна Режим из апостериорное распределение. MAP можно использовать для получения точечная оценка ненаблюдаемой величины на основе эмпирических данных. Это тесно связано с методом максимальная вероятность (ML) оценка, но использует расширенный цель оптимизации который включает предварительное распространение (который дает количественную оценку дополнительной информации, доступной благодаря предварительному знанию связанного события) по количеству, которое необходимо оценить. Поэтому оценку MAP можно рассматривать как регуляризация оценки максимального правдоподобия.

Описание

Предположим, что мы хотим оценить ненаблюдаемый параметр популяции на основании наблюдений . Позволять быть выборочное распределение из , так что это вероятность когда основной параметр населения . Тогда функция:

известен как функция правдоподобия и оценка:

оценка максимального правдоподобия .

Теперь предположим, что предварительное распространение над существуют. Это позволяет лечить как случайная переменная как в Байесовская статистика. Мы можем рассчитать апостериорное распределение из с помощью Теорема Байеса:

куда функция плотности , это область .

Затем метод максимальной апостериорной оценки оценивает как Режим апостериорного распределения этой случайной величины:

Знаменатель апостериорного распределения (так называемый предельная вероятность ) всегда положительна и не зависит от и поэтому не играет никакой роли в оптимизации. Обратите внимание, что оценка MAP совпадает с оценкой ML, когда априорная равномерно (то есть постоянная функция ).

Когда функция потерь имеет форму

в качестве переходит в 0, Байесовская оценка приближается к оценке MAP при условии, что распределение квазивогнутая.[1] Но, как правило, оценка MAP не является Байесовская оценка пока не является дискретный.

Вычисление

Оценки MAP можно рассчитать несколькими способами:

- Аналитически, когда режим (ы) апостериорного распределения может быть представлен в закрытая форма. Это тот случай, когда сопряженные приоры используются.

- Через числовой оптимизация такой как метод сопряженных градиентов или же Метод Ньютона. Обычно для этого требуется первое или второе производные, которые необходимо оценивать аналитически или численно.

- Через модификацию алгоритм максимизации ожидания. Для этого не требуются производные от апостериорной плотности.

- Через Метод Монте-Карло с помощью имитация отжига

Ограничения

Хотя для оценки MAP требуются только мягкие условия, чтобы быть предельным случаем Оценка Байеса (под функцией потерь 0–1),[1] это не очень характерно для байесовских методов в целом. Это связано с тем, что оценки MAP являются точечными оценками, тогда как байесовские методы характеризуются использованием распределений для обобщения данных и вывода выводов: таким образом, байесовские методы имеют тенденцию сообщать апостериорные иметь в виду или же медиана вместо этого вместе с достоверные интервалы. Причина в том, что эти оценки оптимальны при квадратичной ошибке и потере линейной ошибки соответственно, которые более репрезентативны для типичных функции потерь —И для непрерывного апостериорного распределения нет функции потерь, которая предполагает, что MAP является оптимальной точечной оценкой. Кроме того, апостериорное распределение часто может не иметь простой аналитической формы: в этом случае распределение можно смоделировать с помощью Цепь Маркова Монте-Карло методы, в то время как оптимизация для поиска его режима (-ов) может быть трудной или невозможной.[нужна цитата ]

Во многих типах моделей, таких как модели смеси, задняя часть может быть мультимодальный. В таком случае обычно рекомендуется выбирать самый высокий режим: это не всегда возможно (глобальная оптимизация является сложной проблемой), а в некоторых случаях даже возможной (например, когда идентифицируемость возникают вопросы). Более того, самая высокая мода может быть нехарактерна для большинства задних зубов.

Наконец, в отличие от оценок ML, оценка MAP не является инвариантен при репараметризации. Переход от одной параметризации к другой включает введение якобиана, влияющего на положение максимума.[2]

В качестве примера разницы между байесовскими оценками, упомянутыми выше (средняя и медианная оценки), и использованием оценки MAP, рассмотрим случай, когда есть необходимость классифицировать входные данные. как положительный, так и отрицательный (например, займы как рискованные или безопасные). Предположим, есть всего три возможных гипотезы о правильном методе классификации. , и с задними 0,4, 0,3 и 0,3 соответственно. Предположим, что дан новый экземпляр, , классифицирует его как положительный, тогда как два других классифицируют его как отрицательный. Использование оценки MAP для правильного классификатора , классифицируется как положительный, тогда как байесовские оценки усредняют все гипотезы и классифицируют как отрицательный.

Пример

Предположим, что нам дана последовательность из IID случайные переменные и априорное распределение дан кем-то . Мы хотим найти оценку MAP для . Обратите внимание, что нормальное распределение само по себе сопряженный предшествующий, так что мы сможем найти закрытое решение аналитически.

Максимизируемая функция тогда задается выражением

что эквивалентно минимизации следующей функции от :

Таким образом, мы видим, что Оценщик MAP для μ определяется как

что оказывается линейной интерполяцией между априорным средним и средним выборочным, взвешенными по их соответствующим ковариациям.

Случай называется неинформативным априорным и приводит к неточно определенному априорному распределению вероятностей; в этом случае

Рекомендации

- ^ а б Бассет, Роберт; Дериде, Хулио (30.01.2018). «Максимальные апостериорные оценки как предел байесовских оценок». Математическое программирование: 1–16. arXiv:1611.05917. Дои:10.1007 / s10107-018-1241-0. ISSN 0025-5610.

- ^ Мерфи, Кевин П. (2012). Машинное обучение: вероятностная перспектива. Кембридж, Массачусетс: MIT Press. С. 151–152. ISBN 978-0-262-01802-9.

- ДеГрут, М. (1970). Оптимальные статистические решения. Макгроу-Хилл. ISBN 0-07-016242-5.

- Соренсон, Гарольд В. (1980). Оценка параметров: принципы и проблемы. Марсель Деккер. ISBN 0-8247-6987-2.

- Халд, Андерс (2007). "Вывод Гаусса нормального распределения и метод наименьших квадратов, 1809". История параметрического статистического вывода от Бернулли до Фишера, 1713–1935 гг.. Нью-Йорк: Спрингер. С. 55–61. ISBN 978-0-387-46409-1.